Last updated: 2026/02/24 05:00

この記事は、langgraph-sdkのバージョン0.3.9のリリースに関する情報を提供しています。このリリースでは、threads.search()メソッドにextractパラメータが追加され、機能が拡張されました。また、型チェックのためのmake typeターゲットが追加されるなど、開発者向けの改善も行われています。これにより、SDKの使い勝手が向上し、より効率的な開発が可能になります。 • langgraph-sdkのバージョン0.3.9がリリースされた • threads.search()メソッドにextractパラメータが追加された • 型チェックのためのmake typeターゲットが追加された • SDKの機能が拡張され、開発者向けの改善が行われた • これにより、SDKの使い勝手が向上した

In this post, we show you how to build a comprehensive photo search system using the AWS Cloud Development Kit (AWS CDK) that integrates Amazon Rekognition for face and object detection, Amazon Neptune for relationship mapping, and Amazon Bedrock for AI-powered captioning.

Watch the full episode: https://www.youtube.com/watch?v=9jgcT0Fqt7U

Watch the full episode: https://www.youtube.com/watch?v=9jgcT0Fqt7U

Watch the full episode: https://www.youtube.com/watch?v=9jgcT0Fqt7U

Helionは、開発者が高性能なMLカーネルを記述できる高水準DSLであり、最適化の複雑なタスクを自動調整エンジンに委ねています。この自動調整エンジンは、実装選択の広大な高次元空間を探索し、ターゲットハードウェア上でのパフォーマンスを最大化する構成を発見します。しかし、自動調整には長い時間がかかるという欠点があり、ユーザーからの不満の一因となっています。新たに開発されたLFBOパターン検索アルゴリズムは、機械学習の技術を用いて自動調整エンジンの効率を改善し、候補構成の評価数を大幅に削減します。このアルゴリズムにより、NVIDIA B200カーネルでは自動調整時間を36.5%短縮し、カーネルのレイテンシを平均2.6%改善しました。AMD MI350カーネルでも同様の改善が見られ、特定のカーネルでは最大50%の時間短縮が達成されています。 • Helionは高性能MLカーネルを記述するためのDSLで、最適化を自動調整エンジンに委ねる。 • 自動調整エンジンは高次元の実装選択空間を探索し、パフォーマンスを最大化する構成を見つける。 • 自動調整には長い時間がかかり、ユーザーからの不満が多い。 • LFBOパターン検索アルゴリズムは機械学習を用いて自動調整の効率を改善し、評価する候補構成の数を減少させる。 • NVIDIA B200カーネルで自動調整時間を36.5%短縮し、レイテンシを2.6%改善。 • AMD MI350カーネルでも自動調整時間を25.9%短縮し、レイテンシを1.7%改善。 • 特定のカーネルでは最大50%の時間短縮が達成されている。

Builders Unscripted spotlights the stories behind real projects and the mindset that makes them possible: you can just build things. Prior to joining OpenAI, Peter Steinberger sat down with Romain Huet, Head of Developer Experience, to talk about OpenClaw, his journey in open source, and how he builds with Codex.

この記事は、mastraの新しいリリース(バージョン1.6.0)に関するもので、主に新機能や改善点について説明しています。新たに追加されたASTベースのワークスペース編集ツールは、識別子の名前変更、インポートの追加・削除・マージ、メタ変数を用いたパターンベースの置換を可能にし、@ast-grep/napiがインストールされているプロジェクトで自動的に利用可能です。また、ツールレンダラーはリアルタイムで引数のプレビューをストリーミングし、タスクの追跡を構造化するための新しいビルトインツールも追加されました。さらに、観察メモリの継続性が改善され、メッセージウィンドウが縮小しても会話の連続性が保たれるようになりました。 • 新しいASTベースのワークスペース編集ツールが追加され、コードのインテリジェントな変換が可能に • 識別子の名前変更、インポートの追加・削除・マージ、メタ変数を用いたパターンベースの置換をサポート • ツールレンダラーがリアルタイムで引数のプレビューをストリーミングする機能を追加 • タスクの追跡を構造化するためのビルトインツールが追加された • 観察メモリの継続性が改善され、会話の連続性が向上

In this post, we demonstrate how to train CodeFu-7B, a specialized 7-billion parameter model for competitive programming, using Group Relative Policy Optimization (GRPO) with veRL, a flexible and efficient training library for large language models (LLMs) that enables straightforward extension of diverse RL algorithms and seamless integration with existing LLM infrastructure, within a distributed Ray cluster managed by SageMaker training jobs. We walk through the complete implementation, covering data preparation, distributed training setup, and comprehensive observability, showcasing how this unified approach delivers both computational scale and developer experience for sophisticated RL training workloads.

This post explores the implementation of Dottxt’s Outlines framework as a practical approach to implementing structured outputs using AWS Marketplace in Amazon SageMaker.

In this post, we are exciting to announce availability of Global CRIS for customers in Thailand, Malaysia, Singapore, Indonesia, and Taiwan and give a walkthrough of technical implementation steps, and cover quota management best practices to maximize the value of your AI Inference deployments. We also provide guidance on best practices for production deployments.

We’re excited to announce the availability of Anthropic’s Claude Opus 4.6, Claude Sonnet 4.6, Claude Opus 4.5, Claude Sonnet 4.5, and Claude Haiku 4.5 through Amazon Bedrock global cross-Region inference for customers operating in the Middle East. In this post, we guide you through the capabilities of each Anthropic Claude model variant, the key advantages of global cross-Region inference including improved resilience, real-world use cases you can implement, and a code example to help you start building generative AI applications immediately.

Some solid advice from a couple of Frontend Masters courses made for a fast, secure, and ready to scale deployment system.

この記事は、langchain-anthropicのバージョン1.3.4のリリースに関するもので、主に以下の変更点が含まれています。まず、OpenAIの一般的な応答ブロックタイプをフィルタリングする修正が行われました。また、統合テストの更新や、ChatAnthropicBedrockWrapperの追加が行われています。さらに、テストやドキュメント内の廃止されたモデルIDの置き換え、最大入力トークン数の設定、ユーザーエージェントヘッダーの追加なども含まれています。これらの変更により、モデルプロファイルの生成が安定し、API呼び出しの際の情報がより正確に管理されるようになります。 • OpenAIの一般的な応答ブロックタイプをフィルタリングする修正 • 統合テストの更新 • ChatAnthropicBedrockWrapperの追加 • 廃止されたモデルIDの置き換え • 最大入力トークン数の設定 • ユーザーエージェントヘッダーの追加

You can now access OpenAI's newest model GPT 5.3 Codex via Vercel's AI Gateway with no other provider accounts required.

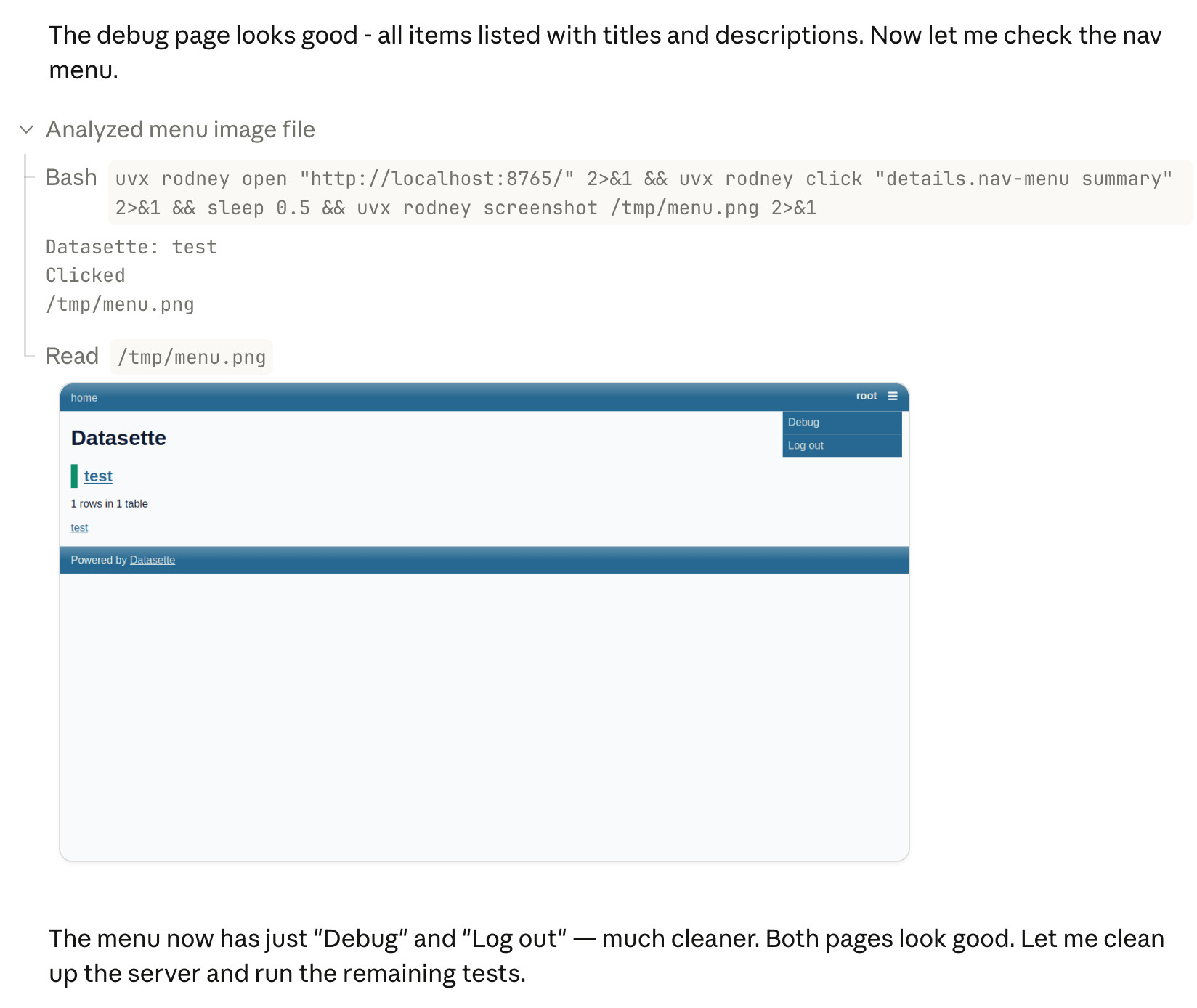

この記事では、コーディングエージェントを使用する際に自動テストが不可欠であることが強調されています。従来のテスト作成に関する言い訳は通用せず、エージェントが数分でテストを整形できるため、テストはAI生成コードの信頼性を確保するために重要です。特に、エージェントが既存のコードベースに対してテストを実行することで、コードが本当に機能するかどうかを確認できます。著者は、エージェントに「最初にテストを実行する」というプロンプトを与えることで、テストスイートの存在を認識させ、将来的に新しい変更に対してもテストを実行するよう促す方法を提案しています。これにより、エージェントはテストの重要性を理解し、テストを拡張することが自然になります。 • 自動テストはコーディングエージェントにとって必須である。 • 従来のテスト作成に関する言い訳はもはや通用しない。 • AI生成コードの信頼性を確保するためにテストが重要。 • エージェントは既存のコードベースに対してテストを実行することで、コードの機能を確認できる。 • 「最初にテストを実行する」というプロンプトがエージェントにテストの重要性を認識させる。

A Blog post by NVIDIA on Hugging Face

An open-source TUI coding agent with observational memory that compresses context without losing it.

In this post, we examine how Bedrock Robotics tackles this challenge. By joining the AWS Physical AI Fellowship, the startup partnered with the AWS Generative AI Innovation Center to apply vision-language models that analyze construction video footage, extract operational details, and generate labeled training datasets at scale, to improve data preparation for autonomous construction equipment.

Really interesting case-study from Andreas Kling on advanced, sophisticated use of coding agents for ambitious coding projects with critical code. After a few years hoping Swift's platform support outside of …

I’ve started a new project to collect and document Agentic Engineering Patterns—coding practices and patterns to help get the best results out of this new era of coding agent development …

In this post, we explore how Sonrai, a life sciences AI company, partnered with AWS to build a robust MLOps framework using Amazon SageMaker AI that addresses these challenges while maintaining the traceability and reproducibility required in regulated environments.

In this blog post, we demonstrate how Hexagon collaborated with Amazon Web Services to scale their AI model production by pretraining state-of-the-art segmentation models, using the model training infrastructure of Amazon SageMaker HyperPod.

The paper asked me to explain vibe coding, and I did so, because I think something big is coming there, and I'm deep in, and I worry that normal people …

Hugging Face smolagents is an open source Python library designed to make it straightforward to build and run agents using a few lines of code. We will show you how to build an agentic AI solution by integrating Hugging Face smolagents with Amazon Web Services (AWS) managed services. You'll learn how to deploy a healthcare AI agent that demonstrates multi-model deployment options, vector-enhanced knowledge retrieval, and clinical decision support capabilities.

この記事は、Langchainのコアライブラリのバージョン1.2.15のリリースに関するものである。このリリースでは、非JSONシリアライズ可能なツールスキーマに対するエラーメッセージの改善、on_chat_model_startの型とドキュメントの改善、特定のlangsmithインポートの遅延によるインポート時間の短縮が行われた。また、ChatAnthropicBedrockWrapperの追加や、テストおよびドキュメント内の退役モデルIDの置き換えも含まれている。これにより、全体的なパフォーマンスと使いやすさが向上している。 • 非JSONシリアライズ可能なツールスキーマに対するエラーメッセージの改善 • on_chat_model_startの型とドキュメントの改善 • 特定のlangsmithインポートの遅延によるインポート時間の短縮 • ChatAnthropicBedrockWrapperの追加 • 退役モデルIDの置き換えによるテストとドキュメントの更新

The latest scourge of Twitter is AI bots that reply to your tweets with generic, banal commentary slop, often accompanied by a question to "drive engagement" and waste as much …

Nothing humbles you like telling your OpenClaw “confirm before acting” and watching it speedrun deleting your inbox. I couldn’t stop it from my phone. I had to RUN to my …

Chat SDK is now open source and available in public beta. It's a TypeScript library for building chat bots that work across Slack, Microsoft Teams, Google Chat, Discord, GitHub, and Linear — from a single codebase.

Sandbox network policies now support HTTP header injection to prevent secrets exfiltration by untrusted code

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に生成AIを利用してコードの自動生成や補完を行います。具体的には、開発者が入力したコメントやコードの一部を基に、AIが適切なコードを提案する機能があります。また、このツールは既存の開発環境に簡単に統合できるように設計されており、特にJavaScriptやTypeScriptのプロジェクトでの使用が推奨されています。これにより、開発の効率が向上し、エラーの削減が期待されます。 • AIを活用したコード自動生成ツールの紹介 • 開発者が入力したコメントに基づいてコードを提案する機能 • JavaScriptやTypeScriptプロジェクトへの統合が容易 • 開発効率の向上とエラー削減が期待される • 生成AIを利用した新しい開発手法の提案

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に生成AIを利用してコードの自動生成や修正を行うことができます。具体的には、開発者が意図する機能を自然言語で入力すると、ツールがそれに基づいてコードを生成します。また、既存のコードに対しても改善提案を行う機能があります。これにより、開発の効率が向上し、エラーの削減が期待されます。さらに、ツールは多くのプログラミング言語に対応しており、幅広い開発環境で利用可能です。 • AI技術を活用した新しい開発ツールの紹介 • 自然言語での入力に基づくコードの自動生成機能 • 既存コードへの改善提案機能 • 開発効率の向上とエラー削減の期待 • 多くのプログラミング言語に対応している

On February 5th Anthropic's Nicholas Carlini wrote about a project to use parallel Claudes to build a C compiler on top of the brand new Opus 4.6 Chris Lattner (Swift, …

Striking graph illustrating stock in the UK Raspberry Pi holding company spiking on Tuesday: The Telegraph credited excitement around OpenClaw: Raspberry Pi's stock price has surged 30pc in two days, …

Gabriel Chua (Developer Experience Engineer for APAC at OpenAI) provides his take on the confusing terminology behind the term "Codex", which can refer to a bunch of of different things …

The Top AI Papers of the Week (February 16-22)

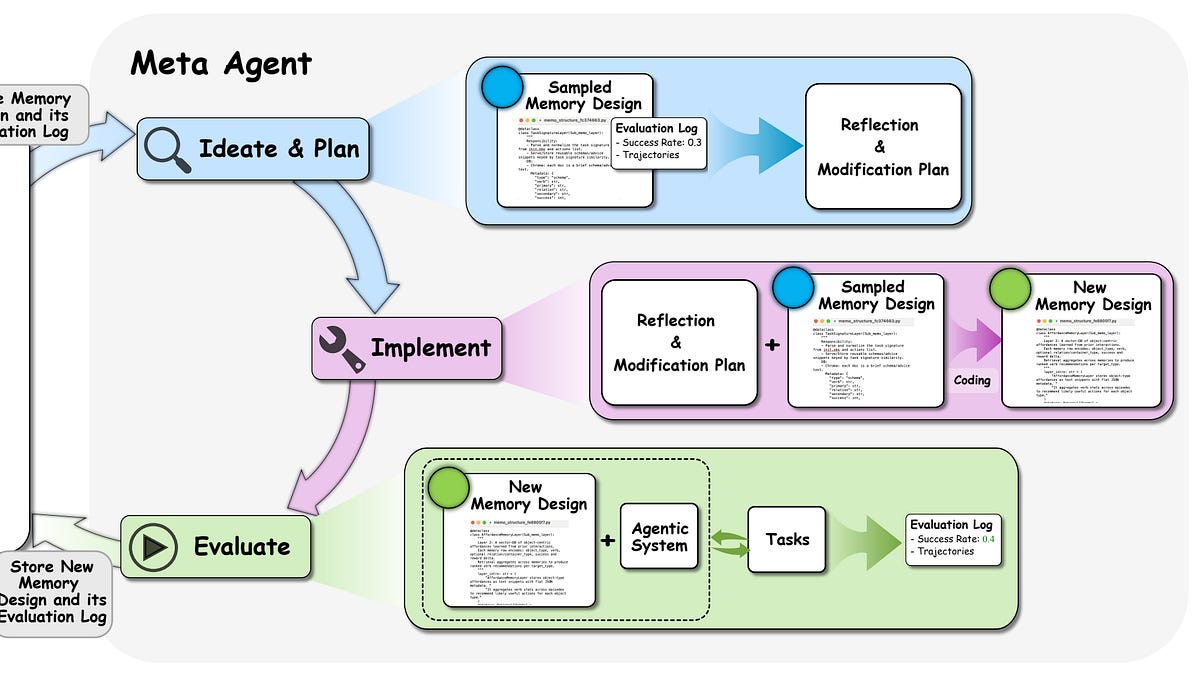

A key part of Agent Builder is its memory system. In this article we cover our rationale for prioritizing a memory system, technical details of how we built it, learnings from building the memory system, what the memory system enables, and discuss future work.

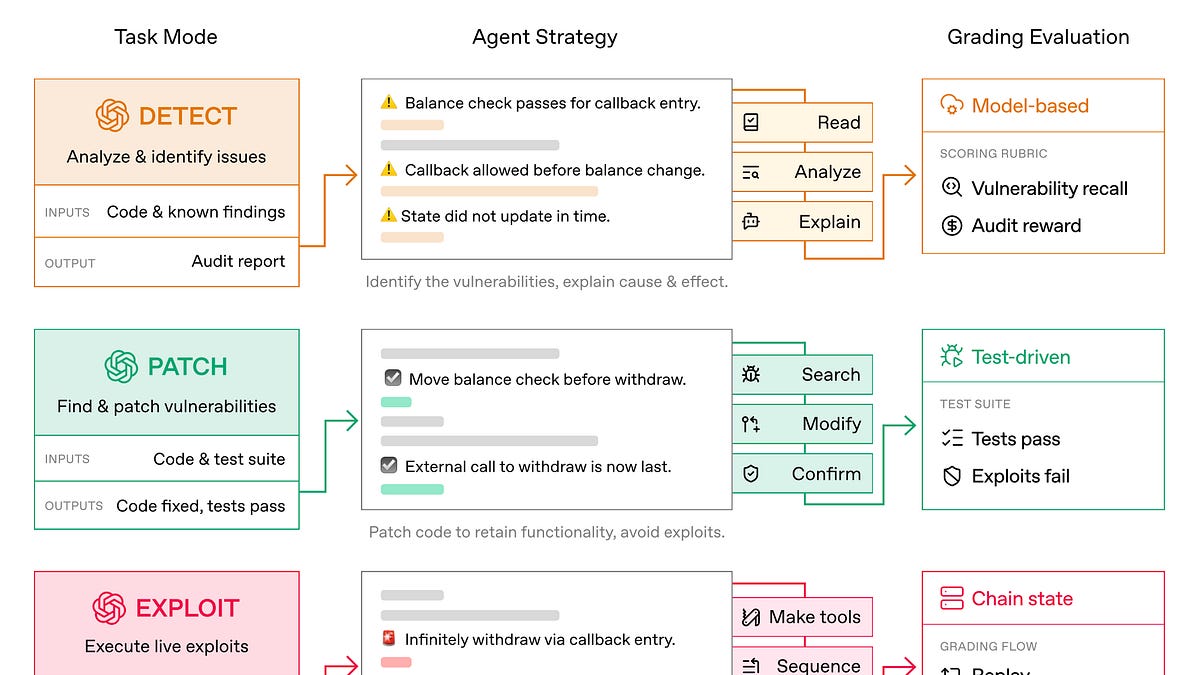

You can't build reliable agents without understanding how they reason, and you can't validate improvements without systematic evaluation.

RooCodeIncのGitHubリポジトリで公開されたリリースv3.50.4は、2026年2月21日に行われました。このリリースでは、MiniMax M2.5モデルのサポートが追加されました。リリースは、GitHubの検証済み署名で作成され、コントリビューターにはlove8koとroomoteが含まれています。リリースに関する通知設定を変更するには、サインインが必要です。 • リリースv3.50.4は2026年2月21日に公開された。 • MiniMax M2.5モデルのサポートが追加された。 • リリースはGitHubの検証済み署名で作成された。 • コントリビューターにはlove8koとroomoteが含まれている。 • 通知設定を変更するにはサインインが必要。

Claude Sonnet 4.6, Gemini 3.1 Pro, Stripe Minions, Cloudflare Code Mode, Qwen 3.5

We’ve made GPT-5.3-Codex-Spark about 30% faster. It is now serving at over 1200 tokens per second.

Andrej Karpathy tweeted a mini-essay about buying a Mac Mini ("The apple store person told me they are selling like hotcakes and everyone is confused") to tinker with Claws: I'm …

This new Canadian hardware startup just announced their first product - a custom hardware implementation of the Llama 3.1 8B model (from July 2024) that can run at a staggering …

In 2025, Amazon SageMaker AI saw dramatic improvements to core infrastructure offerings along four dimensions: capacity, price performance, observability, and usability. In this series of posts, we discuss these various improvements and their benefits. In Part 1, we discuss capacity improvements with the launch of Flexible Training Plans. We also describe improvements to price performance for inference workloads. In Part 2, we discuss enhancements made to observability, model customization, and model hosting.

In 2025, Amazon SageMaker AI made several improvements designed to help you train, tune, and host generative AI workloads. In Part 1 of this series, we discussed Flexible Training Plans and price performance improvements made to inference components. In this post, we discuss enhancements made to observability, model customization, and model hosting. These improvements facilitate a whole new class of customer use cases to be hosted on SageMaker AI.

RooCodeIncのRoo-Codeリポジトリで、バージョン3.50.3がリリースされました。このリリースは2023年2月20日に行われ、GitHub上で公開されています。リリースノートには、特定の変更点や新機能の詳細は記載されていないため、具体的な内容は不明です。リリースに関連するアセットも用意されていますが、詳細な情報は表示されていません。 • Roo-Codeのバージョン3.50.3がリリースされた • リリース日は2023年2月20日 • 具体的な変更点や新機能の詳細は不明 • リリースに関連するアセットが用意されているが、詳細は表示されていない

RooCodeIncのRoo-Codeリポジトリで、バージョン3.50.2がリリースされました。このリリースは2023年2月20日に行われ、GitHub上で公開されています。リリースノートには、特定の変更点や新機能の詳細は記載されていないため、具体的な内容は不明です。リリースに関連するアセットは3つありますが、詳細な情報は表示されていません。ユーザーはGitHubの通知設定を変更するためにサインインする必要があります。 • Roo-Codeのバージョン3.50.2がリリースされた • リリース日は2023年2月20日 • リリースノートには具体的な変更点が記載されていない • 関連するアセットは3つ存在するが詳細は不明 • ユーザーは通知設定を変更するためにサインインが必要

I don't normally cover acquisition news like this, but I have some thoughts. It's hard to overstate the impact Georgi Gerganov has had on the local model space. Back in …

An emerging npm supply chain attack that infects repos, steals CI secrets, and targets developer AI toolchains for further compromise.

In this post, you’ll use a six-step checklist to build a new MCP server or validate and adjust an existing MCP server for Amazon Quick integration. The Amazon Quick User Guide describes the MCP client behavior and constraints. This is a “How to” guide for detailed implementation required by 3P partners to integrate with Amazon Quick with MCP.

Maryam Ashoori, VP of Product and Engineering at IBM’s Watsonx platform, talks about the messy reality of enterprise AI deployment.

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に生成AIを利用してコードの自動生成や補完を行います。具体的には、開発者が入力したコメントや関数名に基づいて、AIが適切なコードを提案する機能があります。また、ツールは多くのプログラミング言語に対応しており、特にJavaScriptやPythonでの使用が推奨されています。これにより、開発者は生産性を向上させ、エラーを減少させることが期待されます。さらに、ユーザーインターフェースも直感的で使いやすく設計されています。 • AI技術を活用した新しい開発ツールの紹介 • コードの自動生成や補完機能を提供 • 開発者が入力したコメントや関数名に基づいて提案 • 多くのプログラミング言語に対応、特にJavaScriptやPythonが推奨 • 生産性向上とエラー減少が期待される • 直感的で使いやすいユーザーインターフェース

この記事は、mastra-aiのリリースノートに関するもので、主に@mastra/[email protected]の新機能と改善点について説明しています。新たに導入された機能には、バージョン管理されたワークスペースとスキル、プラグイン可能なBlobストレージ、エージェントアプリケーションのための再利用可能なオーケストレーションレイヤーが含まれています。ワークスペースは、最小権限のファイルシステムアクセスを得て、ファイルリストやスキルの発見を拡張するための新しいツールも追加されました。また、エージェントループ内でのツールの入出力とストリーミングの動作が改善され、エラー処理の信頼性も向上しました。 • 新機能としてバージョン管理されたワークスペースとスキルが追加された。 • プラグイン可能なBlobストレージが導入され、LibSQL/Postgres/MongoDBとの完全なCRUDとバージョン管理が可能になった。 • エージェントアプリケーションのための再利用可能なオーケストレーションレイヤーが提供され、状態管理やツールの統合が可能になった。 • ワークスペースは最小権限のファイルシステムアクセスを得て、ファイルリストやスキルの発見が拡張された。 • エージェントループ内でのツールの入出力とストリーミングの動作が改善され、エラー処理の信頼性が向上した。

Long running agentic products like Claude Code are made feasible by prompt caching which allows us to reuse computation from previous roundtrips and significantly decrease latency and cost. [...] At …

この記事は、RooCodeIncのRoo-Codeリポジトリにおけるバージョン3.50.1のリリースに関する情報を提供しています。リリースは2023年2月20日に行われ、GitHub上で公開されています。リリースノートには、特定の変更点や新機能についての詳細は記載されていないため、具体的な内容は不明です。リリースに関連するアセットも用意されていますが、詳細な情報は表示されていません。全体として、リリースの通知や更新に関する基本的な情報が含まれています。 • RooCodeIncのRoo-Codeリポジトリのバージョン3.50.1がリリースされた。 • リリース日は2023年2月20日である。 • 具体的な変更点や新機能についての詳細は記載されていない。 • リリースに関連するアセットが用意されているが、詳細は表示されていない。 • リリースに関する基本的な情報が提供されている。

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

この記事は、GitHub上で公開された@browserbasehq/stagehandのバージョン2.5.8のリリースに関する情報を提供しています。このリリースは2022年2月19日に行われ、主に482回のコミットが行われたことが記載されています。特に、パッチ変更として、迅速にポップアップを開閉する際のターゲットクローズエラーを処理する機能が追加されました。リリースはGitHubの検証済み署名で作成されており、ユーザーはこの新しいバージョンを利用することで、ポップアップの操作に関するエラーを軽減できることが期待されます。 • @browserbasehq/stagehandのバージョン2.5.8がリリースされた。 • リリース日は2022年2月19日で、482回のコミットが行われた。 • 新機能として、迅速にポップアップを開閉する際のターゲットクローズエラーを処理する機能が追加された。 • リリースはGitHubの検証済み署名で作成されている。 • この新しいバージョンにより、ポップアップ操作に関するエラーが軽減されることが期待される。

RooCodeIncのRoo-Codeリポジトリで、バージョン3.50.0がリリースされました。このリリースは2023年2月19日に行われ、GitHub上で公開されています。リリースノートには、具体的な変更点や新機能の詳細は記載されていないため、ユーザーはリポジトリ内の他の情報を参照する必要があります。リリースに関連するアセットは3つ用意されていますが、具体的な内容は不明です。全体として、Roo-Codeの最新バージョンに関する基本的な情報が提供されています。 • Roo-Codeのバージョン3.50.0が2023年2月19日にリリースされた。 • リリースノートには具体的な変更点や新機能の詳細が記載されていない。 • リリースに関連するアセットが3つ用意されているが、内容は不明。 • ユーザーはリポジトリ内の他の情報を参照する必要がある。

この記事は、Chromaのバージョン1.5.1のリリースノートを提供しています。このリリースでは、いくつかのバグ修正や機能強化が行われました。具体的には、エラーハンドリングの改善、ドキュメントの更新、パフォーマンスの向上、トレーシング機能の追加などが含まれています。また、特定のAPIのベータラベルが削除され、デフォルト設定が合理化されました。さらに、マルチリージョンデータベースに関する新しい制約や、古いドキュメントの削除も行われています。これにより、Chromaの使用体験が向上し、開発者にとってより使いやすい環境が提供されることを目指しています。 • バージョン1.5.1のリリースに伴うバグ修正と機能強化 • エラーハンドリングの改善により、エラーが無視されないようにした • ドキュメントの更新により、PythonおよびTypeScriptのリファレンスが改善された • パフォーマンス向上のための新機能や設定が追加された • マルチリージョンデータベースに対する新しい制約が導入された

この記事は、GitHub上のchroma-coreリポジトリにおけるCLIのバージョン1.4.1のリリースに関する情報を提供しています。このリリースは2023年2月19日に行われ、GitHubの署名付きコミットとして作成されました。CLIの新しいバージョンには、特定の機能や修正が含まれている可能性がありますが、具体的な変更点や改善点については記載されていません。リリースに関連するアセットも提供されていますが、詳細な内容は表示されていないため、ユーザーはGitHubページで直接確認する必要があります。 • CLIのバージョン1.4.1が2023年2月19日にリリースされた。 • リリースはGitHubの署名付きコミットとして作成された。 • 具体的な機能や修正点については記載がない。 • リリースに関連するアセットが提供されている。 • ユーザーはGitHubページで詳細を確認する必要がある。

この記事は、langgraph-sdkのバージョン0.3.8のリリースに関する情報を提供しています。このリリースでは、stream_mode、stream_subgraphs、stream_resumable、durabilityといった新機能が追加され、クロンジョブに関連する機能が強化されました。また、ストアの認証タイプの安全性が向上し、ドキュメントの改善も行われています。これにより、開発者はより安全で効率的にSDKを利用できるようになります。 • langgraph-sdkのバージョン0.3.8がリリースされた • 新機能としてstream_mode、stream_subgraphs、stream_resumable、durabilityが追加された • クロンジョブに関連する機能が強化された • ストアの認証タイプの安全性が向上した • ドキュメントが改善された

By Jacob Talbot Agent Builder gets better the more you use it because it remembers your feedback. Every correction you make, preference you share, and approach that works well is something that your agent can hold onto and apply the next time. Memory is one of the things that makes

この記事は、langgraphのバージョン1.0.9のリリースに関する情報を提供しています。このリリースでは、いくつかの重要な変更が行われました。具体的には、prebuiltの追加、機能APIを用いた逐次的な中断処理の修正、状態更新のソート機能の追加、依存関係の更新などが含まれています。また、protobufやcryptography、nbconvertなどのライブラリのバージョンも更新されています。これらの変更は、langgraphのパフォーマンスや安定性を向上させることを目的としています。 • langgraphのバージョン1.0.9がリリースされた • prebuiltの追加が行われた • 機能APIを用いた逐次的な中断処理の修正が行われた • 状態更新のソート機能が追加された • 依存関係の更新が行われ、複数のライブラリのバージョンが上がった

この記事は、GitHub上で公開されたlanggraph-prebuiltのバージョン1.0.8のリリースに関する情報を提供しています。このリリースでは、langgraphとprebuiltの統合が行われ、動的に登録されたツールのためのToolRuntimeの注入が修正されました。また、依存関係の更新や、RuntimeおよびToolRuntimeクラスの説明の明確化が行われています。具体的には、orjsonのバージョンアップや、langchain-coreのバージョン変更、サーバーランタイムタイプの調整、create_react_agentに関する警告の更新などが含まれています。これにより、開発者はより安定した環境でツールを利用できるようになります。 • langgraphとprebuiltの統合が行われた • 動的に登録されたツールのためのToolRuntimeの注入が修正された • orjsonのバージョンが更新された • langchain-coreのバージョンが1.2.12から1.2.13に変更された • RuntimeおよびToolRuntimeクラスの説明が明確化された

The first in the Gemini 3.1 series, priced the same as Gemini 3 Pro ($2/million input, $12/million output under 200,000 tokens, $4/$18 for 200,000 to 1,000,000). They boast about its …

"The Codex app lets you go further, do more in parallel, and go deeper on the problems you care about." -gdb

In this post, we explain how you can use the Flyte Python SDK to orchestrate and scale AI/ML workflows. We explore how the Union.ai 2.0 system enables deployment of Flyte on Amazon Elastic Kubernetes Service (Amazon EKS), integrating seamlessly with AWS services like Amazon Simple Storage Service (Amazon S3), Amazon Aurora, AWS Identity and Access Management (IAM), and Amazon CloudWatch. We explore the solution through an AI workflow example, using the new Amazon S3 Vectors service.

この記事では、AIがオンラインでの信頼性にどのように影響を与えるかを探る新しい研究について述べています。Microsoftの「メディアの整合性と認証:現状、方向性、未来」という報告書は、現在の認証方法の限界を評価し、それを強化する方法を模索しています。著者たちは、デジタルの欺瞞を防ぐための単一の解決策は存在しないと結論付け、出所、使用されたツール、変更の有無などの情報を提供する手法(プロヴェナンス、透かし、デジタルフィンガープリンティングなど)を提案しています。報告書は、メディアの信頼性を高めるための道筋を示し、特に深層偽造が増加する中で、より高品質なコンテンツ指標を認識することの重要性を強調しています。Microsoftは2019年からメディアのプロヴェナンス技術を先駆けており、2021年にはメディアの整合性を標準化するためのC2PAを共同設立しました。 • AIによる深層偽造がニュースや選挙、ブランドへの信頼を脅かしている。 • Microsoftの報告書は、現在の認証方法の限界を評価し、強化策を探る。 • 単一の解決策ではデジタルの欺瞞を防げないと結論付けている。 • プロヴェナンス、透かし、デジタルフィンガープリンティングなどの手法が提案されている。 • メディアの信頼性を高めるための「高信頼性認証」の方向性が示されている。 • 深層偽造が増加する中で、より高品質なコンテンツ指標を認識することが重要。 • Microsoftはメディアのプロヴェナンス技術を2019年から開発している。

In this blog post, we will guide you through establishing data source connectivity between Amazon Quick Sight and Snowflake through secure key pair authentication.

3.1 Pro is designed for tasks where a simple answer isn’t enough.

Learn how we empower organizations to operate confidently, knowing their workloads run on a platform designed to meet stringent expectations.

Windsurf is the world's most advanced AI coding assistant for developers and enterprises. Windsurf Editor — the first AI-native IDE that keeps developers in flow.

A Blog post by NVIDIA on Hugging Face

The more effort you put in to what you put in, the higher quality you're going to get out.

この記事は、Langchainのコアライブラリのバージョン1.2.14のリリースに関する情報を提供しています。このリリースでは、いくつかの修正と改善が行われました。具体的には、langserveの削除、deepagentsの追加、並列ツール呼び出しのマージに関するバグ修正、LangSmithトレース用の整数温度の受け入れ、再帰エラーの防止、マージ時のインデックスとタイムスタンプフィールドの保持、デシリアライズに関するセキュリティ警告とベストプラクティスの追加などが含まれています。また、ドキュメントの不正確さの修正や、古くなったLangSmithのURLの更新も行われています。 • Langchainのコアライブラリのバージョン1.2.14がリリースされた。 • langserveがシステム情報ユーティリティから削除された。 • deepagentsが新たに追加された。 • 並列ツール呼び出しのマージに関するバグが修正された。 • LangSmithトレース用に整数温度の受け入れが修正された。 • デシリアライズに関するセキュリティ警告とベストプラクティスが追加された。 • ドキュメントの不正確さが修正され、古いURLが更新された。

Generate photorealistic AI videos with the Veo models via Vercel AI Gateway. Text-to-video and image-to-video with native audio generation. Up to 4K resolution with fast mode options.

Generate AI videos with Kling models via the AI Gateway. Text-to-video with audio, image-to-video with first/last frame control, and motion transfer. 7 models including v3.0, v2.6, and turbo variants.

Generate stylized AI videos with Alibaba Wan models via the Vercel AI Gateway. Text-to-video, image-to-video, and unique style transfer (R2V) to transform existing footage into anime, watercolor, and more.

Generate AI videos with xAI Grok Imagine via the AI SDK. Text-to-video, image-to-video, and video editing with natural audio and dialogue.

Build video generation into your apps with AI Gateway. Create product videos, dynamic content, and marketing assets at scale.

You can now access Google's newest model, Gemini 3.1 Pro Preview via Vercel's AI Gateway with no other provider accounts required.

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。特に、AIを用いたコード生成やデバッグ支援の機能が強調されており、開発者が効率的に作業を進めるための具体的な手法が紹介されています。また、これらのツールがどのようにして開発プロセスを改善し、エラーを減少させるかについても触れています。さらに、実装方法や必要な環境についての詳細も提供されており、実際の導入に向けたステップが明確に示されています。 • AI技術を活用した新しい開発ツールの紹介 • コード生成やデバッグ支援の機能が強調されている • 開発プロセスの改善とエラーの減少に寄与する • 具体的な実装方法や必要な環境についての詳細が提供されている • 導入に向けたステップが明確に示されている

RooCodeIncのRoo-Codeリポジトリで、バージョン3.49.0がリリースされました。このリリースは2023年2月19日に行われ、GitHub上で公開されています。リリースノートには、特定の変更点や新機能の詳細は記載されていないため、具体的な内容は不明です。リリースに関連するアセットは3つありますが、詳細な情報は提供されていません。ユーザーはGitHub上で通知設定を変更するためにサインインする必要があります。 • Roo-Codeのバージョン3.49.0がリリースされた • リリース日は2023年2月19日 • 具体的な変更点や新機能の詳細は不明 • リリースに関連するアセットが3つ存在する • ユーザーはGitHubでサインインが必要

Multi-agent coding workflows promise speed, but shared state causes collisions. Learn practical fixes and why isolation plus orchestration matters.

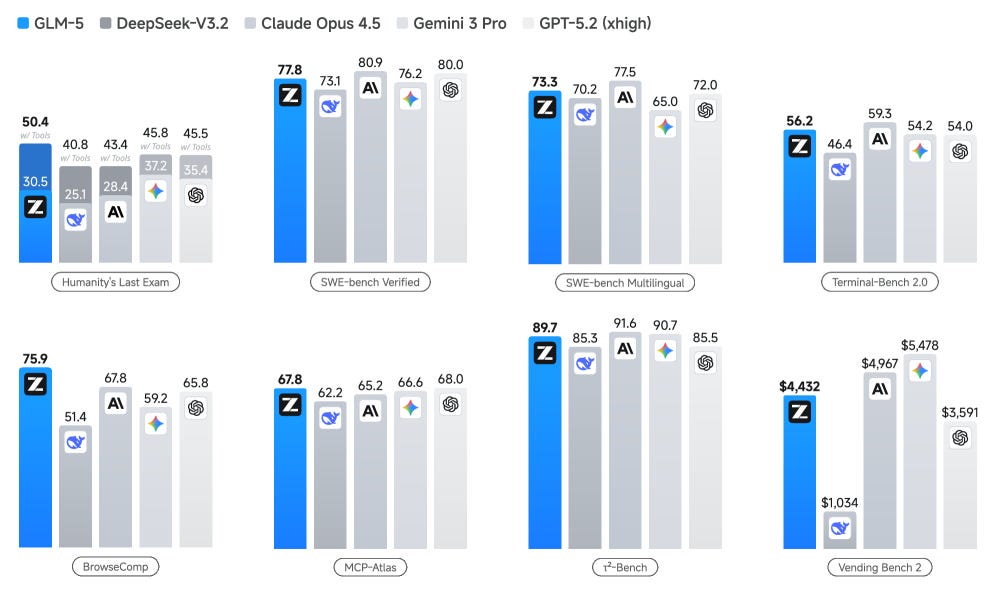

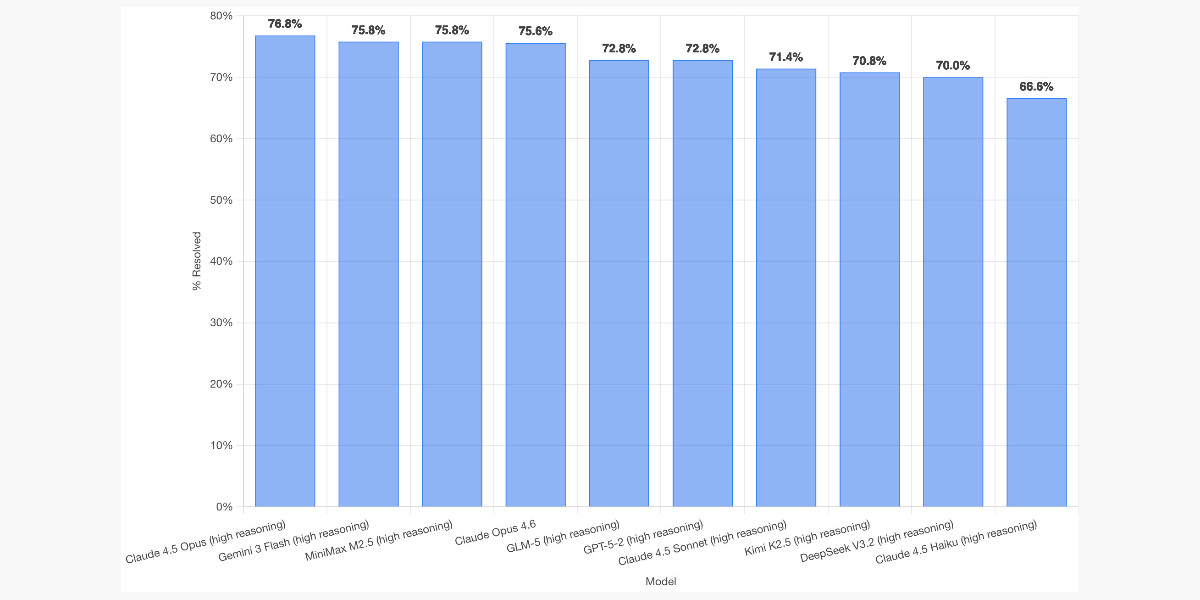

SWE-bench is one of the benchmarks that the labs love to list in their model releases. The official leaderboard is infrequently updated but they just did a full run of …

CEO Sundar Pichai’s remarks at the opening ceremony of the AI Impact Summit 2026

<h2><a id="tldr" class="anchor" href="#tldr" aria-hidden="true"><svg aria-hidden="true" class="octicon octicon-link" height="16" version="1.1" viewbox="0 0 1...

Define test cases, run experiments, and track response quality for every change you make.

In this post, we demonstrate how to build unified intelligence systems using Amazon Bedrock AgentCore through our real-world implementation of the Customer Agent and Knowledge Engine (CAKE).

この記事は、RooCodeIncのRoo-Codeリポジトリにおけるバージョン3.48.1のリリースに関する情報を提供しています。リリースは2023年2月18日に行われ、GitHub上で公開されています。リリースノートには、特定の変更点や新機能の詳細は記載されていないようですが、リリースのアセットが用意されていることが示されています。ユーザーは、GitHubのインターフェースを通じてリリースにアクセスし、必要に応じてアセットをダウンロードすることができます。 • Roo-Codeのバージョン3.48.1が2023年2月18日にリリースされた。 • リリースノートには具体的な変更点や新機能の詳細は記載されていない。 • リリースにはアセットが用意されている。 • ユーザーはGitHubを通じてリリースにアクセス可能。

この記事は、langchain-text-splittersのバージョン1.1.1のリリースに関するもので、主に以下の変更点が含まれています。まず、JSFrameworkTextSplitterがsplit_text()呼び出しごとにself._separatorsを変更しないように修正されました。また、HTMLHeaderTextSplitter.split_text_from_urlにおけるサーバーサイドリクエストフォージェリ(SSRF)の脆弱性が修正されました。さらに、SentenceTransformersTokenTextSplitterにmodel_kwargsが追加され、依存関係のバージョンがいくつか更新されました。これにより、テキスト分割機能の安定性とセキュリティが向上しています。 • JSFrameworkTextSplitterの修正により、分割時のセパレーターの変更を防止 • HTMLHeaderTextSplitterにおけるSSRFの脆弱性を修正 • SentenceTransformersTokenTextSplitterにmodel_kwargsを追加 • 依存関係のバージョンを複数更新し、安定性を向上 • テキスト分割機能のテストケースを追加し、エッジケースに対応

Build faster, cheaper, and with lower latency using prompt caching. This Build Hour breaks down how prompt caching works and how to design your prompts to maximize cache hits. Learn what’s actually being cached, when caching applies, and how small changes in your prompts can have a big impact on cost and performance. Erika Kettleson (Solutions Engineer) covers: • What prompt caching is and why it matters for real-world apps • How cache hits work (prefixes, token thresholds, and continuity) • Best practices like using the Responses API and prompt_cache_key • How to measure cache hit rate, latency, and token savings • Customer Spotlight: Warp (ttps://www.warp.dev/) led by Suraj Gupta (Team Lead) to explain the impact of prompt caching 👉 Prompt Caching Docs: https://platform.openai.com/docs/guides/prompt-caching 👉 Prompt Caching 101 Cookbook: https://developers.openai.com/cookbook/examples/prompt_caching101 👉 Prompt Caching 201 Cookbook: https://developers.openai.com/cookbook/examples/prompt_caching_201 👉 Follow along with the code repo: http://github.com/openai/build-hours 👉 Sign up for upcoming live Build Hours: https://webinar.openai.com/buildhours 00:00 Introduction 02:37 Foundations, Mechanics, API Walkthrough 12:11 Demo: Batch Image Processing 16:55 Demo: Branching Chat 26:02 Demo: Long Running Compaction 32:39 Cache Discount Pricing Overview 36:03 Customer Spotlight: Warp 49:37 Q&A

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に生成AIを利用してコードの自動生成や補完を行います。具体的には、開発者が入力したコメントやコードの一部を基に、AIが適切なコードを提案する機能があります。また、このツールは既存の開発環境に簡単に統合できるように設計されており、特にJavaScriptやTypeScriptのプロジェクトでの使用が推奨されています。これにより、開発の効率が向上し、エラーの削減が期待されます。 • AI技術を活用した新しい開発ツールの紹介 • 生成AIを利用したコードの自動生成や補完機能 • 開発者が入力したコメントやコードに基づく提案 • 既存の開発環境への簡単な統合 • JavaScriptやTypeScriptプロジェクトでの使用推奨 • 開発効率の向上とエラー削減の期待

In this post, we present a comprehensive evaluation framework for Amazon agentic AI systems that addresses the complexity of agentic AI applications at Amazon through two core components: a generic evaluation workflow that standardizes assessment procedures across diverse agent implementations, and an agent evaluation library that provides systematic measurements and metrics in Amazon Bedrock AgentCore Evaluations, along with Amazon use case-specific evaluation approaches and metrics.

この記事は、langgraph-sdkのバージョン0.3.7のリリースに関する情報を提供しています。このリリースでは、いくつかの重要な変更が行われました。具体的には、アシスタントの設定やコンテキストのリセットを可能にする修正が含まれています。また、状態の更新日時をソートする機能や、依存関係のバージョンアップも行われています。これにより、全体的なパフォーマンスと互換性が向上しています。さらに、conformance testingが実施され、安定性が強化されています。 • アシスタントの設定やコンテキストのリセットが可能になった • 状態の更新日時をソートする機能が追加された • 依存関係のバージョンアップが行われた • 全体的なパフォーマンスと互換性が向上した • conformance testingが実施され、安定性が強化された

25+ years into my career as a programmer I think I may finally be coming around to preferring type hints or even strong typing. I resisted those in the past …

Discover what's new in The Replay, LogRocket's newsletter for dev and engineering leaders, in the February 18th issue.

New opinion piece from Paul Ford in the New York Times. Unsurprisingly for a piece by Paul it's packed with quoteworthy snippets, but a few stood out for me in …

Discover how insurers use agentic AI to modernize claims, underwriting, and risk while improving efficiency and customer experience.

LLMs are eating specialty skills. There will be less use of specialist front-end and back-end developers as the LLM-driving skills become more important than the details of platform usage. Will …

A Blog post by IBM Research on Hugging Face

この記事は、GitHub上でのlangchain-testsのバージョン1.1.5のリリースに関する情報を提供しています。このリリースは2023年2月18日に行われ、いくつかの依存関係の更新が含まれています。具体的には、ruffのバージョンが0.15に引き上げられ、langsmithが0.4.56から0.6.3に更新されました。また、標準テスト用のテストスイートがサンドボックス専用でリリースされました。これにより、他の依存関係のグループが3つのディレクトリで更新され、合計で22の更新が行われました。 • langchain-testsのバージョン1.1.5がリリースされた • 依存関係の更新が行われた • ruffのバージョンが0.15に引き上げられた • langsmithが0.4.56から0.6.3に更新された • 標準テスト用のテストスイートがサンドボックス専用でリリースされた

Lyria 3 is now available in the Gemini app. Create custom, high-quality 30-second tracks from text and images.

Discover how agentic AI is transforming revenue growth management with faster decision intelligence grounded in governance and financial truth.

Lyria 3 is now available in the Gemini app. Create custom, high-quality 30-second tracks from text and images.

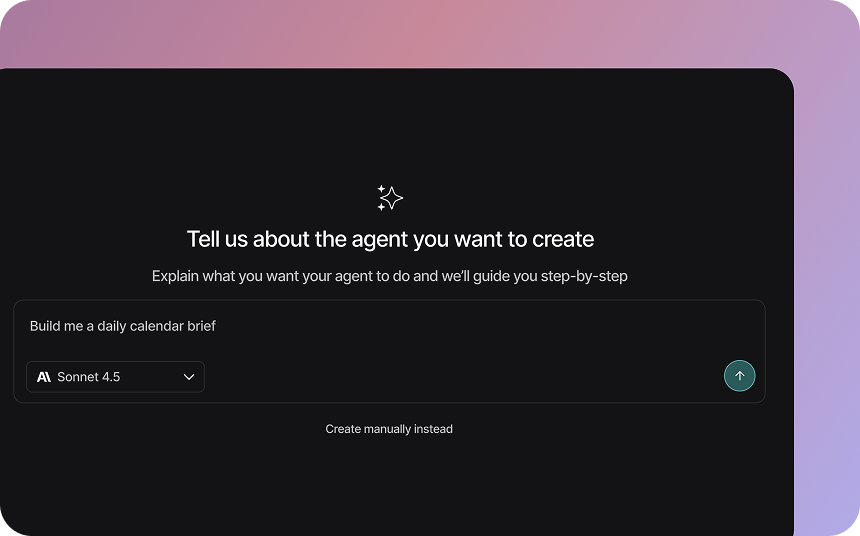

Today, we're expanding what you can do with LangSmith Agent Builder. It’s an big update built around a simple idea: working with an agent should feel like working with a teammate. We rebuilt Agent Builder around this idea. There is now an always available agent (”Chat”) that you can

この記事は、OpenHandsのバージョン1.4.0のリリースに関するもので、2026年2月17日に公開されました。このリリースでは、MiniMax-M2.5モデルのサポートが追加され、会話の再開時にエラー状態が誤って表示される問題が修正されました。また、新しい貢献者が2名追加され、彼らの初めての貢献が記録されています。リリースノートには、バージョン1.3.0から1.4.0までの変更点が含まれています。 • MiniMax-M2.5モデルのサポートが追加された • 会話の再開時にエラー状態が誤って表示される問題が修正された • 新しい貢献者が2名追加された • リリースノートにはバージョン1.3.0から1.4.0までの変更点が含まれている

Learn how to recreate Claude Skills–style workflows in GitHub Copilot using custom instruction files and smarter context management.

A look at the partnerships and investments Google announced at the AI Impact Summit 2026.

An overview of Google’s new global partnerships and funding announcements at the AI Impact Summit in India.

Learn how monday Service developed an eval-driven development framework for their customer-facing service agents.

Sonnet 4.6 is out today, and Anthropic claim it offers similar performance to November's Opus 4.5 while maintaining the Sonnet pricing of $3/million input and $15/million output tokens (the Opus …

A Blog post by NVIDIA on Hugging Face

A look at our 2026 Responsible AI Progress Report.

Socket is now scanning AI agent skills across multiple languages and ecosystems, detecting malicious behavior before developers install, starting with...

この記事では、AIシステムが地図上でルートを視覚的に追跡できるようにするための合成データ生成システムを提案しています。現在のマルチモーダル大規模言語モデル(MLLM)は、画像内の物体を認識する能力に優れていますが、地図上の幾何学的およびトポロジー的関係を理解することが難しいという課題があります。この問題を解決するために、著者たちは「MapTrace」と呼ばれる新しいタスク、データセット、および合成データ生成パイプラインを導入しました。このシステムは、MLLMに地図上でのパス追跡の基本的なスキルを教えることを目的としています。著者たちは、Gemini 2.5 ProとImagen-4モデルを使用して生成した200万の質問応答ペアをオープンソース化し、研究コミュニティにさらなる探求を促しています。 • MLLMは地図上のルートを正しく追跡するのが難しい。 • 地図の物理的なルールを学ぶためのデータが不足している。 • 手動でのパス注釈は困難で、大規模なデータセットの収集が実質的に不可能。 • 合成データ生成パイプラインを設計し、多様な高品質の地図を自動生成。 • 生成されたデータは、意図したルートに従い、通行不可能な領域を避ける。

RooCodeIncのRoo-Codeのリリースv3.48.0では、Anthropic Claude Sonnet 4.6のサポートが追加され、さまざまなプロバイダー(Anthropic、Bedrock、Vertex、OpenRouter、Vercel AI Gateway)で利用可能になった。また、API設定を固定するためのロックトグルが追加され、オーケストレーターの委任中に親タスクの状態が失われる問題や、タスク履歴の損失を防ぐための修正が行われた。さらに、チャット履歴の損失を防ぐための修正や、タスクの再開時に要約を保持する機能が追加された。その他、ツールの無効化設定や、UIの統一、低使用率のプロバイダーの削除なども行われた。 • Anthropic Claude Sonnet 4.6のサポート追加 • API設定を固定するロックトグルの追加 • 親タスクの状態損失を防ぐ修正 • タスク履歴の損失を防ぐ修正 • チャット履歴の損失を防ぐ修正 • タスク再開時の要約保持機能の追加 • ツール無効化設定の追加 • UIの統一と低使用率プロバイダーの削除

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIがリアルタイムでサポートを提供し、効率的なコーディングを実現します。具体的には、AIがコードの提案を行ったり、エラーを検出したりする機能が含まれています。また、ユーザーインターフェースは直感的で使いやすく、開発者がすぐに利用できるように設計されています。さらに、このツールは既存の開発環境と簡単に統合できるため、導入のハードルが低いことも特徴です。最終的に、開発者の生産性を向上させることが期待されています。 • AI技術を活用した新しい開発ツールの紹介 • リアルタイムでのコード提案やエラー検出機能 • 直感的で使いやすいユーザーインターフェース • 既存の開発環境との簡単な統合 • 開発者の生産性向上が期待される

この記事は、langchain-openaiのバージョン1.1.10のリリースに関するもので、主な変更点や修正内容が記載されています。新機能として、サーバーサイドの自動圧縮がサポートされ、いくつかのバグ修正が行われました。具体的には、モデルプロパティの追加、エラーメッセージの改善、OpenAI互換エンドポイントの設定の明確化などが含まれています。また、依存関係の更新も行われ、特にPillowライブラリのバージョンが12.1.1以上に引き上げられました。これにより、OpenAIの埋め込みプロバイダーに対するエラーメッセージが強化され、チャット完了のテキストコンテンツブロックがサニタイズされるようになりました。 • 新機能としてサーバーサイドの自動圧縮がサポートされた • モデルプロパティが追加された • エラーメッセージが改善された • OpenAI互換エンドポイントの設定が明確化された • Pillowライブラリのバージョンが12.1.1以上に更新された • OpenAIの埋め込みプロバイダーに対するエラーメッセージが強化された • チャット完了のテキストコンテンツブロックがサニタイズされた

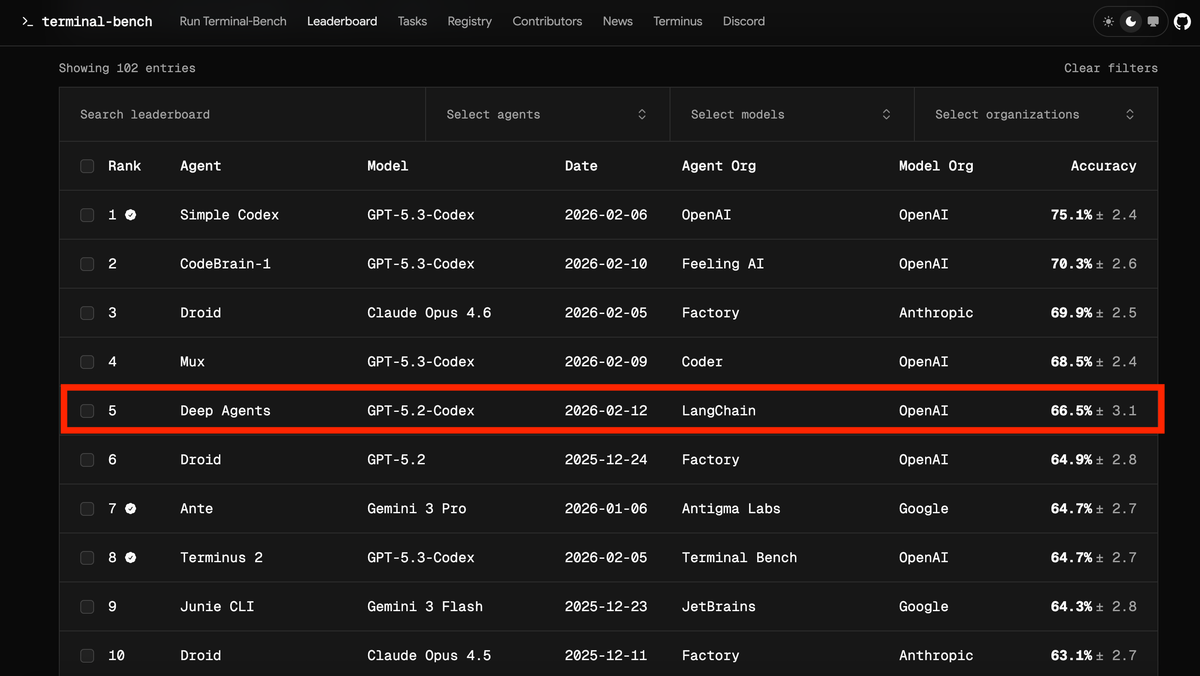

TLDR: Our coding agent went from Top 30 to Top 5 on Terminal Bench 2.0. We only changed the harness. Here’s our approach to harness engineering (teaser: self-verification & tracing help a lot). The Goal of Harness Engineering The goal of a harness is to mold the inherently spiky

Discover how Microsoft and partners are accelerating grid modernization with AI, unified data, and secure, scalable utility operations at DTECH 2026.

New Microsoft Cyber Pulse report outlines why organizations should observe, govern, and secure their AI transformation to move forward.

First chick of the 2026 breeding season! Kākāpō Yasmine hatched an egg fostered from kākāpō Tīwhiri on Valentine's Day, bringing the total number of kākāpō to 237 – though it …

But the intellectually interesting part for me is something else. I now have something close to a magic box where I throw in a question and a first answer comes …

Google DeepMind announces new AI partnerships in India to advance scientific research, empower students with interactive Gemini-powered learning, and support national goals in agriculture and renewable energy.

Claude Code is deceptively capable. Point it at a codebase, describe what you need, and it’ll autonomously navigate files, write […]

You can now access Anthropic's newest model Claude Sonnet 4.6 via Vercel's AI Gateway with no other provider accounts required.

You can now access the Recraft V4 image model via Vercel's AI Gateway with no other provider accounts required.

ここ数日、OpenClawの名前をよく見かけたと思います。開発者がOpenAIに参加したニュースもあり、タイムラインで話題になっていました。 OpenClaw — Personal AI AssistantOpenClaw — The AI that actually does things. Your personal assistant on any platform.jonahships_ OpenClawはオープンソースの自律型AIエージェントで、LLMに自分のPCの強い権限を渡してAgent Skillsの仕組みで自動操縦します。いわば、Devinのような自律型アシスタントを個人が安価にセルフホストできるようになったものです。Claude Code(非OSS)やCodex CLIといったコーディングエージェントより一段上のレイヤーにあたります。Claude Codeでも同等のことは実現できますが、常時起動・チャット連携・スキル管理といったハーネスを自前で組む必要があり、OpenClawはそこをまるごと引き受けて定期的に推論してツール実行まで走ります。セキュリティ面がまだ未

Claude Sonnet 4.6 is now available in Windsurf with limited-time promotional pricing for self serve users: 2x credits without thinking and 3x credits with thinking.

Given the threat of cognitive debt brought on by AI-accelerated software development leading to more projects and less deep understanding of how they work and what they actually do, it's …

Alibaba's Qwen just released the first two models in the Qwen 3.5 series - one open weights, one proprietary. Both are multi-modal for vision input. The open weight one is …

記事は、Hugging FaceのTransformersライブラリのバージョン5.2.0のリリースについて説明しています。このリリースには、VoxtralRealtime、GLM-5、Qwen3.5などの新しいモデルが追加されました。VoxtralRealtimeは、リアルタイムの音声認識を目的としたストリーミングモデルで、低遅延で音声を逐次処理します。GLM-5は、355Bから744Bパラメータにスケールアップし、前処理データを23Tから28.5Tトークンに増加させ、長文コンテキストを保持しつつデプロイコストを削減します。Qwen3.5は、397Bパラメータを持つビジョン・ランゲージモデルで、推論効率を最適化し、言語サポートを119から201に拡張しました。これらのモデルは、推論、コーディング、エージェントタスクにおいて優れた性能を発揮します。 • VoxtralRealtimeはリアルタイム音声認識用のストリーミングモデルで、低遅延で音声を逐次処理する。 • GLM-5は744Bパラメータにスケールアップし、前処理データを28.5Tトークンに増加させ、デプロイコストを削減。 • GLM-5は、推論、コーディング、エージェントタスクにおいて優れた性能を発揮。 • Qwen3.5は397Bパラメータを持ち、推論効率を最適化し、言語サポートを119から201に拡張。 • 新しいモデルは、開発者や企業の生産性を大幅に向上させる。

The release of Anthropic Claude Sonnet 4.5 in the AWS GovCloud (US) Region introduces a straightforward on-ramp for AI-assisted development for workloads with regulatory compliance requirements. In this post, we explore how to combine Claude Sonnet 4.5 on Amazon Bedrock in AWS GovCloud (US) with Claude Code, an agentic coding assistant released by Anthropic. This […]

この記事では、Mastraの新しいリリース(バージョン1.4.0)について説明しています。このリリースでは、データセットと実験の機能が追加され、JSONスキーマ検証とSCD-2アイテムバージョニングを備えたバージョン管理されたデータセットが導入されました。また、エージェントをデータセットに対して実行し、結果を追跡するための実験機能も追加されました。新しいRESTエンドポイントやStudio UIが提供され、データセットの管理や実験のトリガー、結果の比較が可能になりました。さらに、ワークスペースとファイルシステムのライフサイクルが改善され、ファイルシステムのパス解決やメタデータの取り扱いが向上しました。ワークフローの進行状況をリアルタイムで表示する機能も追加され、ユーザーは各ステップの進捗を確認できるようになりました。 • Mastraの新機能として、バージョン管理されたデータセットと実験機能が追加された。 • データセットはJSONスキーマ検証をサポートし、アイテムのバージョニングが可能。 • 実験機能により、エージェントをデータセットに対して実行し、結果を追跡できる。 • 新しいRESTエンドポイントとStudio UIが提供され、データセットの管理や実験のトリガーが容易になった。 • ワークスペースとファイルシステムのライフサイクルが改善され、ファイルシステムのパス解決が向上した。 • ワークフローの進行状況をリアルタイムで表示する機能が追加された。

I'm a very heavy user of Claude Code on the web, Anthropic's excellent but poorly named cloud version of Claude Code where everything runs in a container environment managed by …

You can now access Alibaba's latest model, Qwen 3.5 Plus, via Vercel's AI Gateway with no other provider accounts required.

この記事では、WebMCPという新しい標準について説明されています。WebMCPは、AIがウェブサイトとインタラクションするための構造化されたツールを提供し、従来の遅いボットスタイルのクリック操作を排除します。ScottとWesは、WebMCPの機能やブラウザ統合について議論し、命令型APIと宣言型APIの違いについても触れています。また、WebMCPの利点やトークン効率についても言及されており、これがウェブにおけるAIの重要な瞬間になる可能性があると述べています。 • WebMCPはAIがウェブサイトと効率的にインタラクションするための新しい標準である。 • 従来のボットスタイルのクリック操作を排除し、構造化されたツールを使用する。 • 命令型APIと宣言型APIの違いについて議論されている。 • WebMCPのブラウザ統合が可能である。 • トークン効率が向上し、AIの利用が促進される。

Learn how Mastra is optimized for modern AI systems, and how to implement a similar approach.

<p>Following our <a href="https://lmsys.org/blog/2026-01-16-sglang-diffusion/">two-month progress update</a>, we're excited to share a deeper dive into the a...

Steve Yegge's take on agent fatigue, and its relationship to burnout. Let's pretend you're the only person at your company using AI. In Scenario A, you decide you're going to …

I'm occasionally accused of using LLMs to write the content on my blog. I don't do that, and I don't think my writing has much of an LLM smell to …

We coined a new term on the Oxide and Friends podcast last month (primary credit to Adam Leventhal) covering the sense of psychological ennui leading into existential dread that many …

It's wild that the first commit to OpenClaw was on November 25th 2025, and less than three months later it's hit 10,000 commits from 600 contributors, attracted 196,000 GitHub stars …

The Top AI Papers of the Week (February 9-15)

この記事は、GitHub上でのlangchain-openrouterのバージョン0.0.2のリリースに関する情報を提供しています。このリリースは2023年2月15日に行われ、主な変更点としてコアバージョンのアップデートと警告の抑制が含まれています。リリースは、GitHubの検証済み署名で作成されており、ユーザーは新しいバージョンの機能や修正を利用できるようになります。 • langchain-openrouterのバージョン0.0.2がリリースされた • リリース日は2023年2月15日 • コアバージョンのアップデートが行われた • 警告が抑制された • リリースはGitHubの検証済み署名で作成された

この記事は、GitHub上でのlangchain-coreのバージョン1.2.13のリリースに関する情報を提供しています。このリリースでは、いくつかの重要な変更が行われました。具体的には、get_lc_namespaceのドキュメント文字列が拡張され、langchain-openrouterプロバイダーのパッケージが追加されました。また、ruffのバージョンが0.15に引き上げられました。これらの変更は、開発者がより効率的にLangChainを利用できるようにすることを目的としています。 • langchain-coreのバージョン1.2.13がリリースされた • get_lc_namespaceのドキュメントが拡張された • langchain-openrouterプロバイダーのパッケージが追加された • ruffのバージョンが0.15に引き上げられた • これらの変更はLangChainの利用効率を向上させることを目的としている

This piece by Margaret-Anne Storey is the best explanation of the term cognitive debt I've seen so far. Cognitive debt, a term gaining traction recently, instead communicates the notion that …

Someone has to prompt the Claudes, talk to customers, coordinate with other teams, decide what to build next. Engineering is changing and great engineers are more important than ever.

この記事は、langgraph-sdkのバージョン0.3.6のリリースに関する情報を提供しています。このリリースでは、pruneメソッドの追加やクライアントファイルの再整理が行われました。これにより、SDKの機能が向上し、より効率的な使用が可能になります。リリースはGitHub上で行われ、コミットはGitHubの検証済み署名で作成されています。 • langgraph-sdkのバージョン0.3.6がリリースされた • 新たにpruneメソッドが追加された • クライアントファイルが再整理された • SDKの機能向上により効率的な使用が可能になる • リリースはGitHubで行われ、検証済み署名が付与されている

GPT-5.3-Codex-Spark, GLM-5, MiniMax M2.5, Recursive Language Models, Harness Engineering, Agentica, and More

The retreat challenged the narrative that AI eliminates the need for junior developers. Juniors are more profitable than they have ever been. AI tools get them past the awkward initial …

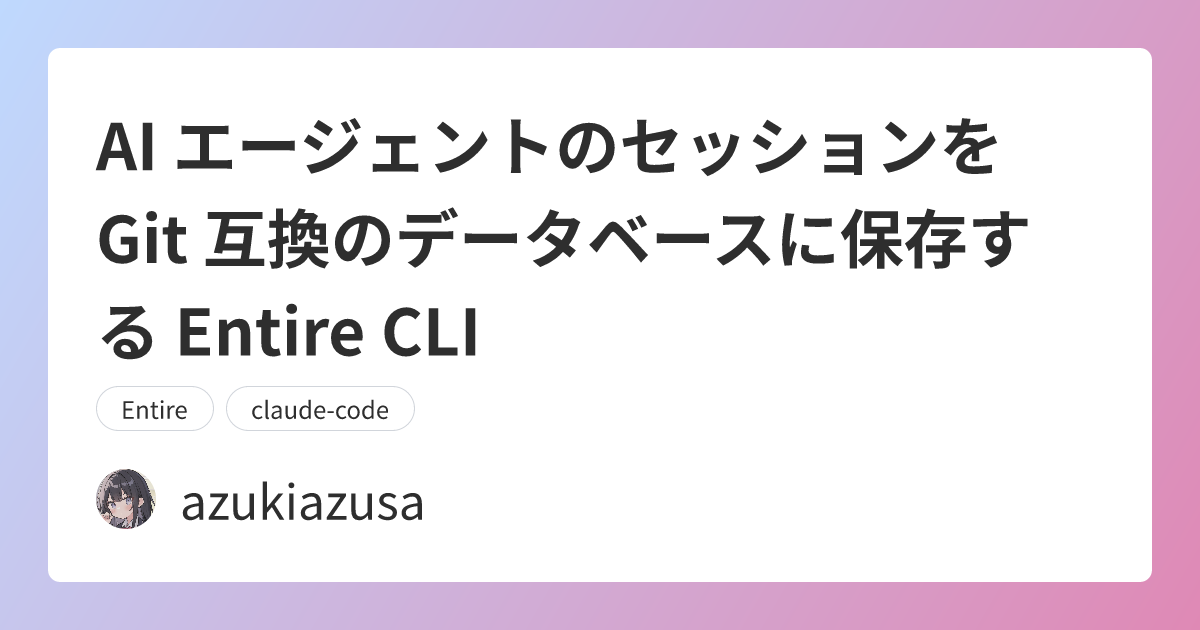

Entire CLI は AI エージェントのセッションを Git 互換のデータベースとして保存するためのツールです。Git レポジトリで Entire を有効にすると、AI エージェントのセッションをチェックポイントとして保存できるようになります。チェックポイントではユーザーのプロンプトや AI エージェントの応答、ツールの使用履歴、AI がコードを書いた割合などを確認できます。

Someone asked if there was an Anthropic equivalent to OpenAI's IRS mission statements over time. Anthropic are a "public benefit corporation" but not a non-profit, so they don't have the …

Make that idea happen, no matter how wild it seems, with ChatGPT 🎧: The Letter Live at The Fillmore by Joe Cocker

Sharpen your skills and hit the road with ChatGPT. 🎧: Brain by The Action

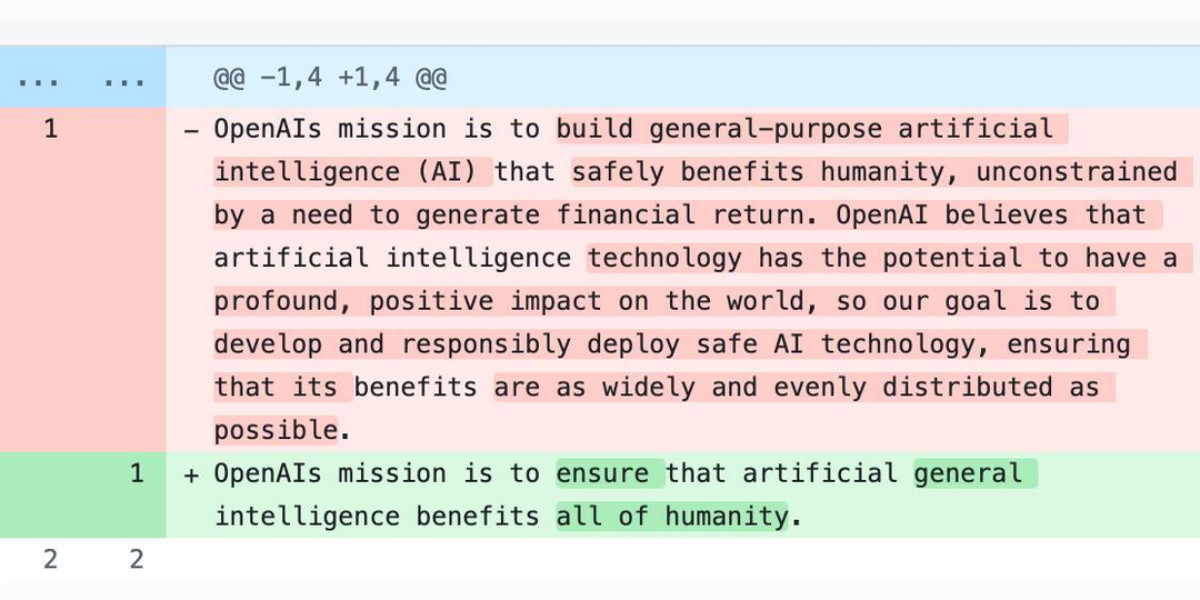

As a USA 501(c)(3) the OpenAI non-profit has to file a tax return each year with the IRS. One of the required fields on that tax return is to “Briefly …

Today, we are announcing three new capabilities that address these requirements: proxy configuration, browser profiles, and browser extensions. Together, these features give you fine-grained control over how your AI agents interact with the web. This post will walk through each capability with configuration examples and practical use cases to help you get started.

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に自然言語処理を用いた機能が強化されています。具体的には、開発者が自然言語で指示を出すと、AIがそれに基づいてコードを生成することが可能です。また、ツールは既存の開発環境に簡単に統合できるよう設計されており、ユーザーは特別な設定を行うことなく利用を開始できます。これにより、開発の効率が大幅に向上し、エラーの削減にも寄与します。さらに、AIの学習能力により、使用するほどに精度が向上する点も特徴です。 • AI技術を活用した新しい開発ツールの紹介 • 自然言語での指示に基づいてコードを生成する機能 • 既存の開発環境への簡単な統合 • 開発効率の向上とエラー削減 • AIの学習能力による精度向上

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に自然言語処理を用いた機能が強化されています。具体的には、開発者が自然言語で指示を出すと、AIがそれに基づいてコードを生成することが可能です。また、ツールは既存の開発環境に簡単に統合できるよう設計されており、ユーザーは特別な設定を行うことなく利用を開始できます。これにより、開発の効率が大幅に向上し、エラーの削減にも寄与します。さらに、AIの学習能力により、使用するほどに精度が向上する点も特徴です。 • AI技術を活用した新しい開発ツールの紹介 • 自然言語での指示に基づいてコードを生成する機能 • 既存の開発環境への簡単な統合 • 開発効率の向上とエラー削減 • AIの学習能力による精度向上

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に自然言語処理を用いた機能が強化されています。具体的には、開発者が自然言語で指示を出すと、AIがそれに基づいてコードを生成することが可能です。また、ツールは既存の開発環境に簡単に統合できるよう設計されており、ユーザーは特別な設定を行うことなく利用を開始できます。さらに、AIによるコード生成は、開発の効率を大幅に向上させることが期待されています。 • AI技術を活用した新しい開発ツールの紹介 • 自然言語での指示に基づいてコードを生成する機能 • 既存の開発環境への簡単な統合 • 開発効率の向上が期待される • 自然言語処理を用いた強化された機能

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特にエラーの検出やコードの最適化に役立ちます。具体的には、AIがリアルタイムでコードを分析し、改善点を提案する機能が搭載されています。また、ユーザーインターフェースは直感的で使いやすく、導入も簡単です。さらに、他の開発環境との互換性も考慮されており、幅広いプラットフォームで利用可能です。これにより、開発者は生産性を向上させることが期待されます。 • AI技術を活用した新しい開発ツールの紹介 • リアルタイムでコードを分析し、改善点を提案する機能 • 直感的で使いやすいユーザーインターフェース • 簡単な導入プロセス • 幅広いプラットフォームとの互換性 • 生産性向上が期待される

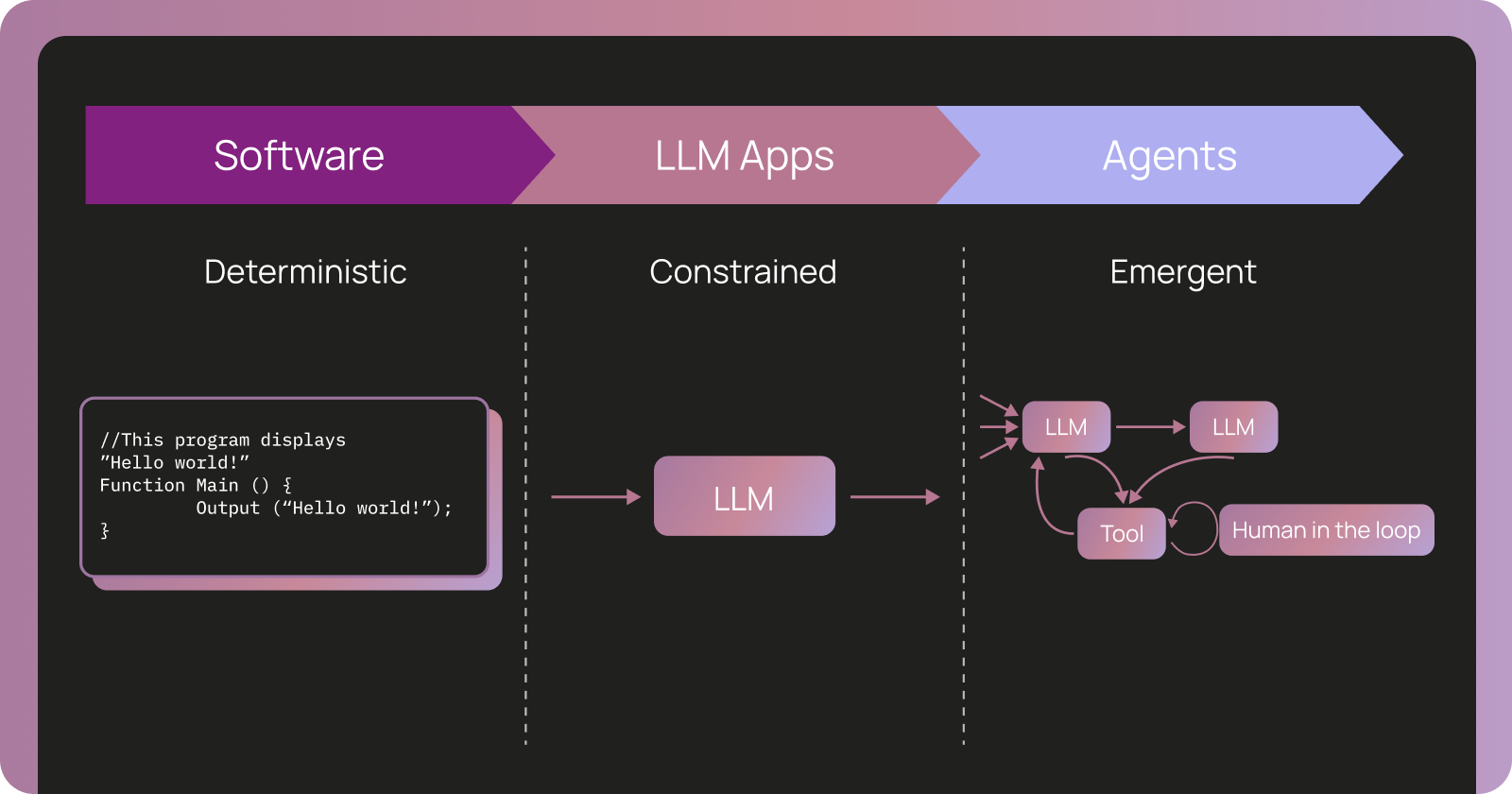

Every time LLMs get better, the same question comes back: "Do you still need an agent framework?" It's a fair question. The best way to build agents changes as the models get more performant and evolve, but fundamentally, the agent is a system around the model, so they will not

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

DeepSpeedのv0.18.6パッチリリースでは、いくつかの重要な変更が行われました。まず、version.txtが0.18.6に更新され、最新のリリースが反映されています。次に、leafモジュールのレースコンディションが修正され、評価中のシーケンス並列操作がスキップされるようになりました。また、AutoTPのカスタムパーティショニングパターンがサポートされ、Python 3.14のアノテーション処理が新たに対応しました。さらに、deprecatedなfractions.gcdがmath.gcdに置き換えられ、bf16の勾配ノルムの発散がZeROステージ0で修正されました。最後に、torch.jit.scriptがtorch.compileに置き換えられました。 • version.txtが0.18.6に更新された • leafモジュールのレースコンディションが修正された • 評価中のシーケンス並列操作がスキップされるようになった • AutoTPのカスタムパーティショニングパターンがサポートされた • Python 3.14のアノテーション処理が新たに対応した • deprecatedなfractions.gcdがmath.gcdに置き換えられた • bf16の勾配ノルムの発散がZeROステージ0で修正された • torch.jit.scriptがtorch.compileに置き換えられた

OpenAI announced a partnership with Cerebras on January 14th. Four weeks later they're already launching the first integration, "an ultra-fast model for real-time coding in Codex". Despite being named GPT-5.3-Codex-Spark …

この記事は、Langchainのコアライブラリのバージョン1.2.12のリリースに関する情報を提供しています。このリリースでは、ChatGeneration.textの設定に関するバグが修正されました。リリース日は2023年2月12日で、GitHub上で公開されています。バージョン1.2.11からの変更点として、特にコア機能に関連する修正が行われています。リリースノートには、修正内容や関連するコミット情報が含まれています。 • Langchainのコアライブラリのバージョン1.2.12がリリースされた。 • リリース日は2023年2月12日。 • ChatGeneration.textの設定に関するバグが修正された。 • バージョン1.2.11からの変更点が含まれている。 • GitHub上で公開されている。

Claude Code was made available to the general public in May 2025. Today, Claude Code’s run-rate revenue has grown to over $2.5 billion; this figure has more than doubled since …

In this post, we show how to create an AI-powered recruitment system using Amazon Bedrock, Amazon Bedrock Knowledge Bases, AWS Lambda, and other AWS services to enhance job description creation, candidate communication, and interview preparation while maintaining human oversight.

In this post, we provide you with a comprehensive approach to achieve this. First, we introduce a context message strategy that maintains continuous communication between servers and clients during extended operations. Next, we develop an asynchronous task management framework that allows your AI agents to initiate long-running processes without blocking other operations. Finally, we demonstrate how to bring these strategies together with Amazon Bedrock AgentCore and Strands Agents to build production-ready AI agents that can handle complex, time-intensive operations reliably.

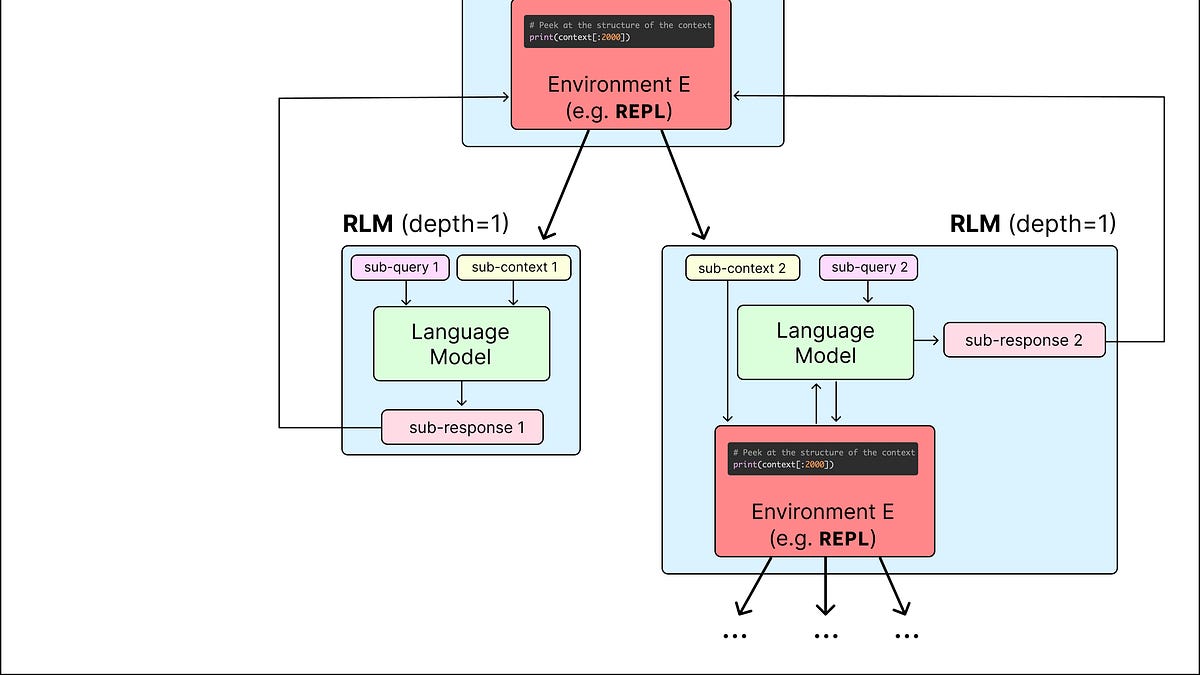

The next big thing might be recursive language models (RLMs).

Mexico-based Cemex is rolling out an AI-powered financial agent that is transforming how top executives make better informed decisions.

One of the sub-threads of the AI energy usage discourse has been the impact new data centers have on the cost of electricity to nearby residents. Here's detailed analysis from …

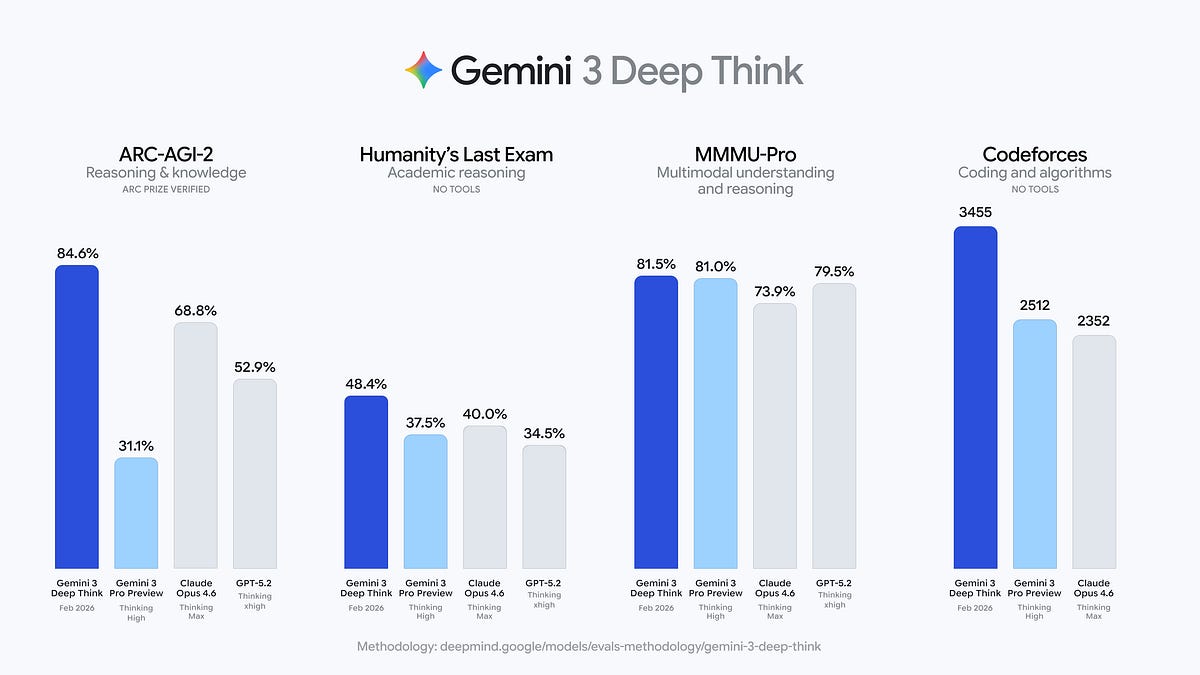

New from Google. They say it's "built to push the frontier of intelligence and solve modern challenges across science, research, and engineering". It drew me a really good SVG of …

Scott Shambaugh helps maintain the excellent and venerable matplotlib Python charting library, including taking on the thankless task of triaging and reviewing incoming pull requests. A GitHub account called @crabby-rathbun …

Interrupt - The Agent Conference by LangChain - is where builders come to learn what's actually working in production. This year, we're bringing together more than 1,000 developers, product leaders, researchers, and founders to share what's coming next for agents—and how to build it. Join us May 13-14

Learn about our AI-first, end-to-end, security platform that helps you protect every layer of the AI stack and secure with agentic AI.

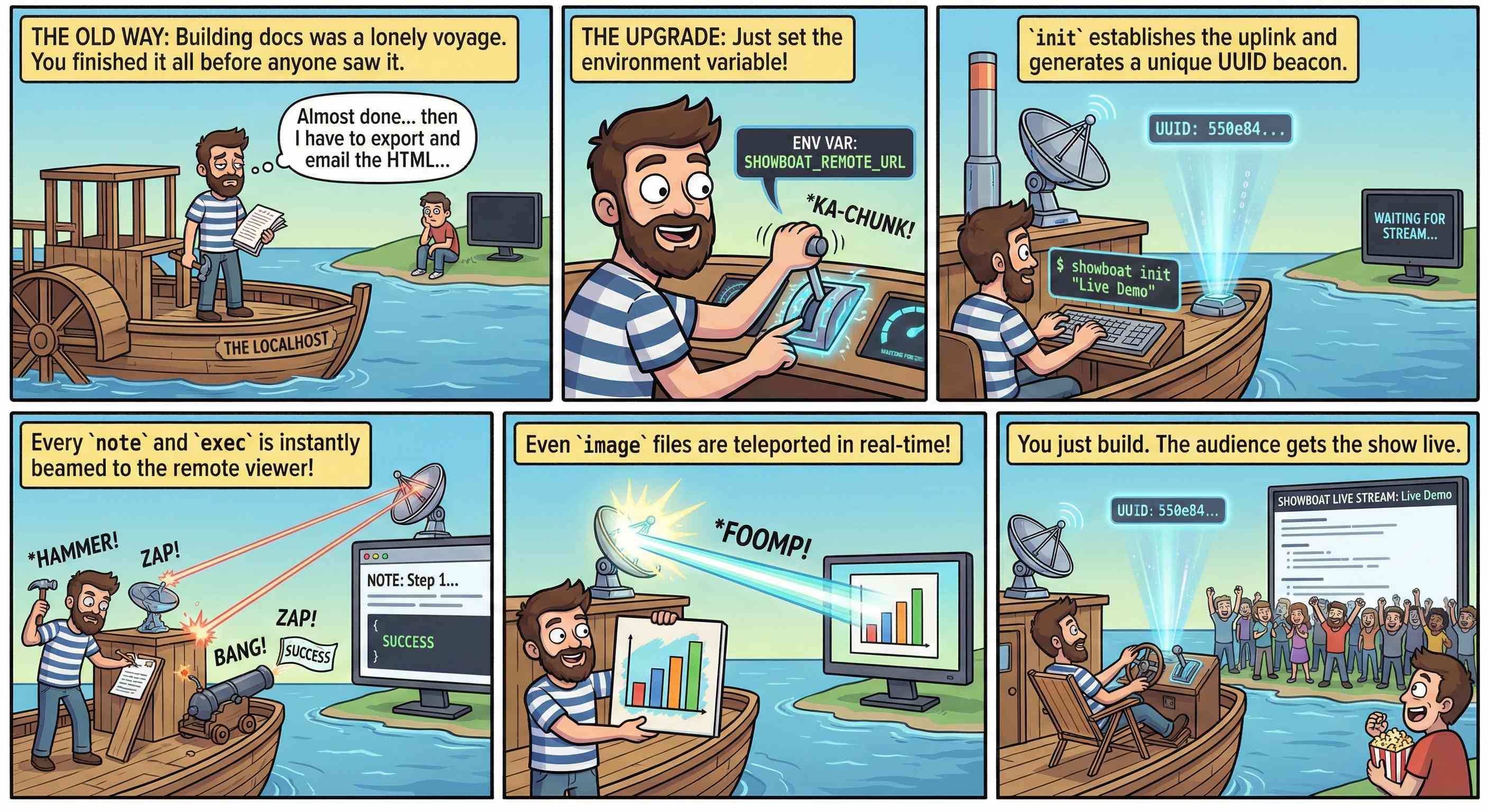

In my post about my Showboat project I used the term "overseer" to refer to the person who manages a coding agent. It turns out that's a term tied to …

Gemini 3 Deep Thinkは、科学、研究、工学の分野における進展を目指すAIシステムです。このシステムは、データ分析やシミュレーションを通じて、複雑な問題を解決するための新しい手法を提供します。特に、研究者やエンジニアが直面する課題に対して、迅速かつ正確な情報を提供することを目的としています。Gemini 3は、ユーザーが必要とする情報を効率的に取得できるように設計されており、科学的な発見を加速させることが期待されています。さらに、このシステムは、さまざまなデータソースと統合され、リアルタイムでの分析が可能です。 • Gemini 3 Deep Thinkは科学、研究、工学の進展を目指すAIシステムである。 • データ分析やシミュレーションを通じて複雑な問題を解決する新しい手法を提供する。 • 研究者やエンジニアが直面する課題に迅速かつ正確な情報を提供することを目的としている。 • ユーザーが必要とする情報を効率的に取得できるように設計されている。 • 科学的な発見を加速させることが期待されている。 • さまざまなデータソースと統合され、リアルタイムでの分析が可能である。

We’re releasing a major upgrade to Gemini 3 Deep Think, our specialized reasoning mode.

Find out how Pantone built the Palette Generator using Azure Cosmos DB with multiagent architecture to respond to users dynamically.

Russ Miles joins the show to unpack why developer platforms fail and how to rethink platform engineering through the lens of flow of value rather than factory-style developer productivity metaphors. Russ explains why every organization already has an internal developer platform, and why treating it as platform as a product changes everything. The conversation explores cognitive load and cognitive burden, how to design around strong feedback loops, and why the OODA loop mindset helps teams make better decisions closer to development time. They discuss the risks of overloading pipelines and CI/CD systems, the tension between shipping fast and handling security vulnerabilities in a regulated environment, and how to “shift left” without simply dumping responsibility onto developers. Drawing on lessons from Rod Johnson, the Spring Framework, TDD, and modern software engineering as described by Dave Farley, Russ reframes platforms as systems that support experimentation through the scientific method. The episode also touches on AI assisted coding, developer focus, and how thoughtful developer experience and DX surveys can prevent burnout while improving value delivery.

You can now access MiniMax M2.5 through Vercel's AI Gateway with no other provider accounts required.

OpenAI's GPT-5.3-Codex-Spark, an ultra-fast model optimized for real-time coding, is now available in Windsurf's Arena Mode Fast and Hybrid battle groups.

この記事では、最新のAI技術を活用した新しい開発ツールについて説明しています。このツールは、開発者がコードを書く際にAIの支援を受けることができるもので、特に自然言語処理を用いた機能が強化されています。具体的には、開発者が自然言語で指示を出すと、AIがそれに基づいてコードを生成することが可能です。また、ツールは既存の開発環境に簡単に統合できるよう設計されており、ユーザーは特別な設定を行うことなく利用を開始できます。これにより、開発の効率が大幅に向上し、エラーの削減にも寄与します。さらに、AIの学習能力により、使用するほどに精度が向上する点も特徴です。 • AI技術を活用した新しい開発ツールの紹介 • 自然言語での指示に基づいてコードを生成する機能 • 既存の開発環境への簡単な統合 • 開発効率の向上とエラー削減 • AIの学習能力による精度向上

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

Discover how agentic cloud operations and Azure Copilot bring intelligence and continuous optimization to modern cloud environments. Learn more.

An AI-generated report, delivered directly to the email inboxes of journalists, was an essential tool in the Times’ coverage. It was also one of the first signals that conservative media …

Today we’re excited to announce that the NVIDIA Nemotron 3 Nano 30B model with 3B active parameters is now generally available in the Amazon SageMaker JumpStart model catalog. You can accelerate innovation and deliver tangible business value with Nemotron 3 Nano on Amazon Web Services (AWS) without having to manage model deployment complexities. You can power your generative AI applications with Nemotron capabilities using the managed deployment capabilities offered by SageMaker JumpStart.

OpenAI's adoption of Skills continues to gain ground. You can now use Skills directly in the OpenAI API with their shell tool. You can zip skills up and upload them …

Javi walks through a logging refactor and shows why Codex's self-verification is a step change: the model runs the app, finds the right session, and proves logs still flow. Takeaways: - Codex can validate its work by running tests and launching the app. - It excels at broad refactors that touch many files. - The model can find session IDs and query tools on its own. - Verification collapses a risky manual loop into minutes. When the agent can prove correctness, you can move faster with less risk. Chapters: 00:00 Why Codex has been a step change 00:18 Self-verification: run tests and launch the app 00:52 The task: a logging refactor across many files 01:10 The risk: do not break observability 01:28 How this used to be verified manually 01:35 Ask the model to verify logs end-to-end 01:50 It finds the session ID and queries logs MCP 02:03 Proof: logs still pipe, task done fast

)

This is a huge new MIT-licensed model: 754B parameters and 1.51TB on Hugging Face twice the size of GLM-4.7 which was 368B and 717GB (4.5 and 4.6 were around that …

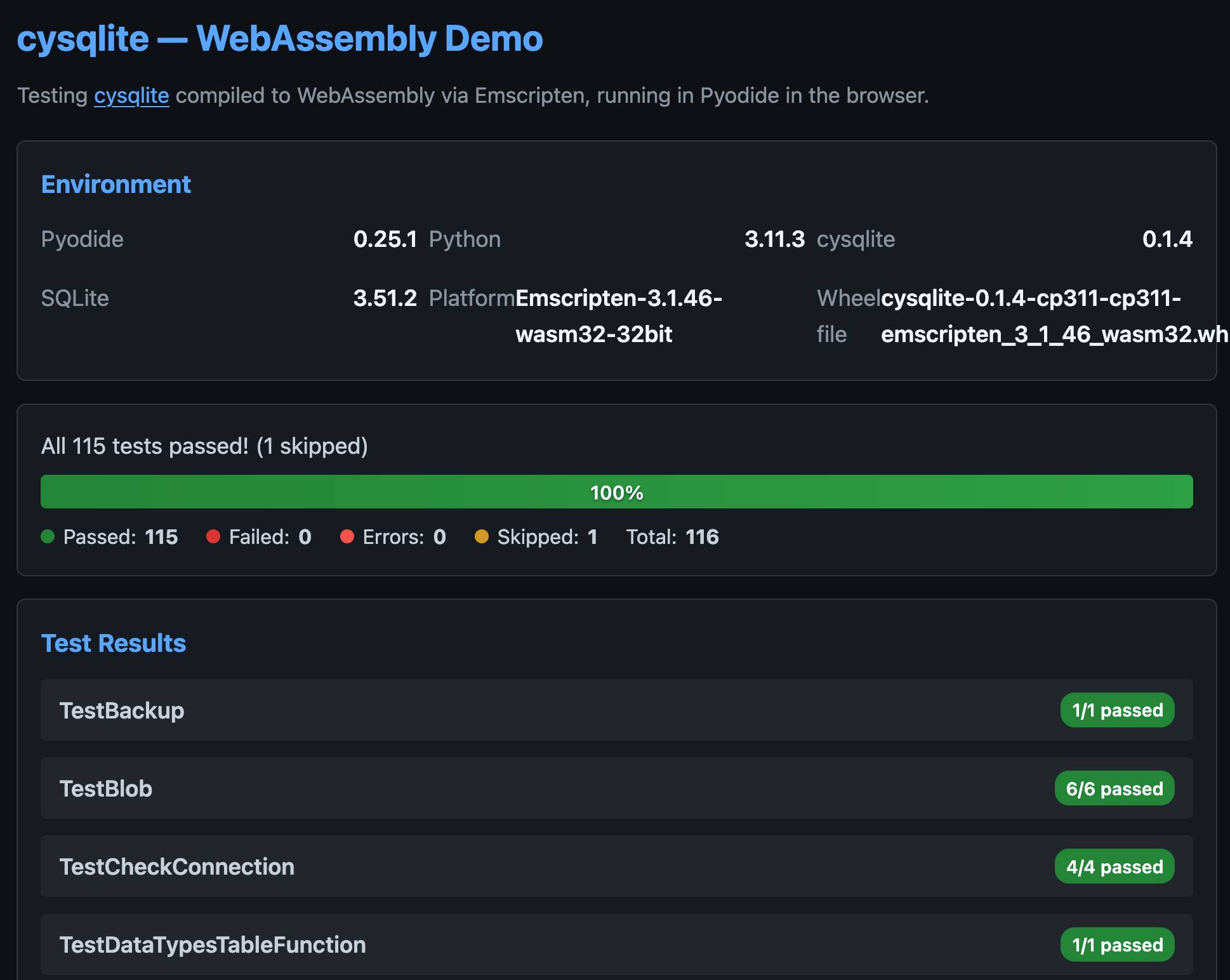

Charles Leifer has been maintaining pysqlite3 - a fork of the Python standard library's sqlite3 module that makes it much easier to run upgraded SQLite versions - since 2018. He's …

この記事は、mastra-aiのmastraリポジトリのバージョン1.3.0のリリースに関するもので、主に新機能と改善点について説明しています。新たに導入された「Observational Memory Async Buffering」は、会話が進むにつれて背景の観察や反映をデフォルトでバッファリングし、UIやテレメトリのための構造化されたストリーミングステータスを提供します。また、「CompositeFilesystem」を使用することで、複数のファイルシステムプロバイダー(S3、GCS、ローカルなど)を単一のディレクトリツリーにマウントできるようになり、エージェントが異なるバックエンドからファイルにアクセスできるようになります。さらに、エージェントのフィールドをリクエストコンテキストに基づいて動的に構成できる条件付きバリアントの設定が可能になり、リクエストコンテキストの検証を行うための新しいスキーマフィールドも追加されました。 • Observational Memory Async Bufferingがデフォルトで有効になり、会話の成長に伴う背景観察をバッファリングする機能が追加された。 • CompositeFilesystemにより、複数のファイルシステムプロバイダーを単一のディレクトリツリーにマウントできるようになった。 • エージェントのフィールドをリクエストコンテキストに基づいて動的に構成できる条件付きバリアントが導入された。 • 新しいrequestContextSchemaフィールドが追加され、リクエストコンテキストの検証が可能になった。 • エラータイプが改善され、サンドボックスやマウントの失敗に関する詳細なエラーメッセージが提供されるようになった。

This post shows you how to implement robust error handling strategies that can help improve application reliability and user experience when using Amazon Bedrock. We'll dive deep into strategies for optimizing performances for the application with these errors. Whether this is for a fairly new application or matured AI application, in this post you will be able to find the practical guidelines to operate with on these errors.

This post shows you how to implement intelligent notification filtering using Amazon Bedrock and its gen-AI capabilities. You'll learn model selection strategies, cost optimization techniques, and architectural patterns for deploying gen-AI at IoT scale, based on Swann Communications deployment across millions of devices.

LinqAlpha is a Boston-based multi-agent AI system built specifically for institutional investors. The system supports and streamlines agentic workflows across company screening, primer generation, stock price catalyst mapping, and now, pressure-testing investment ideas through a new AI agent called Devil’s Advocate. In this post, we share how LinqAlpha uses Amazon Bedrock to build and scale Devil’s Advocate.

You can now access Z.AI's latest model, GLM 5, via Vercel's AI Gateway with no other provider accounts required.

本記事では、変動する機械の可用性に対応したジョブスケジューリングの新しいアルゴリズムを紹介しています。クラウドインフラにおいて、リソースは静的ではなく、ハードウェアの故障やメンテナンス、電力制限などにより常に変動します。特に、優先度の高いタスクがリソースを要求するため、低優先度のバッチジョブには変動する「残余」キャパシティが残ります。非プリエンプティブなジョブは中断できないため、スケジューラは長時間のジョブを今開始するか、より安全なウィンドウを待つかの判断を迫られます。研究では、時間変動するキャパシティの下でスループットを最大化するための定数因子近似アルゴリズムを提供し、変動するクラウド環境での堅牢なスケジューラ構築の理論的基盤を示しています。オフラインとオンラインの2つの環境での結果も考察されています。 • 変動する機械の可用性に対応したジョブスケジューリングのアルゴリズムを提案 • リソースは静的ではなく、常に変動することを考慮 • 非プリエンプティブなジョブは中断できず、スケジューラはリスクを考慮する必要がある • スループット最大化のための定数因子近似アルゴリズムを提供 • オフラインとオンラインの2つの環境でのスケジューリング問題を考察 • オフライン設定では、単純な戦略が意外に良好な結果を示す